当AI大模型从实验室走进大众生活,从智能问答到产业赋能,背后离不开AI服务器的算力支撑。这条串联起算力芯片、光模块、光芯片、PCB、存储、CPU、液冷的产业链,不仅是AI产业的“硬核基建”,更在国产替代的浪潮中展现出强劲的成长活力。本文将从产业底层逻辑、细分领域技术突破、企业竞争优势三个维度,拆解AI服务器产业链的投资价值与发展前景,为读者呈现这条赛道的真实发展图景。

一、AI服务器产业链的增长逻辑,源于需求与替代的双重驱动

AI大模型的规模化应用,让算力需求进入“超摩尔定律”的增长阶段。单台AI服务器的算力可达普通服务器的百倍以上,而一个大型大模型的训练,往往需要数千台AI服务器组成的算力集群持续运行数月。这种需求直接推动互联网大厂、科技企业将资本开支向AI服务器倾斜,2024年国内头部科技企业的AI服务器采购量同比增长超150%,上游元器件厂商的订单排期已排至2025年下半年。

从产业周期来看,AI大模型的迭代还将持续催生算力需求。未来5年,AI大模型将从通用型向行业定制化转型,工业AI质检、金融AI风控、医疗AI影像等垂直领域的应用落地,会让算力需求从集中式的数据中心向边缘端延伸,这意味着AI服务器的应用场景将进一步拓宽,行业增长具备长期可持续性。

国产替代则为产业链企业打开了额外的增长空间。此前,AI服务器核心元器件如高端算力芯片、800G以上光模块主要由海外企业供应,国内企业市场份额不足20%。而2024年以来,国内企业在算力芯片、光芯片等领域的技术突破,让国产AI服务器的核心元器件自给率提升至40%。叠加政策对“东数西算”工程、国产信息技术产业的扶持,国内企业既能承接全球AI产业的算力需求,又能享受国产替代的政策红利,这是海外竞争对手无法比拟的优势。

二、算力芯片:AI服务器的“算力核心”,国产企业实现从0到1的突破

算力芯片是AI服务器的核心组件,其性能直接决定了AI运算的效率。AI运算的并行处理特性,要求算力芯片具备海量的计算单元和高速的内存带宽,这也让算力芯片成为产业链中技术壁垒最高的环节。

寒武纪是国内首家实现云端AI芯片商用的企业,其思元系列芯片已应用于国内头部服务器厂商的AI服务器产品中,2024年上半年寒武纪AI芯片的出货量同比增长220%。从技术层面来看,寒武纪的芯片架构针对AI运算做了深度优化,在推理场景下的算力能效比已接近海外同类产品,随着大模型推理需求的爆发,其产品的商业化进程将进一步加快。

摩尔线程则聚焦于通用GPU的研发,其推出的MTT S系列GPU已支持主流AI框架,能适配AI训练和推理场景。2024年,摩尔线程的GPU产品进入多家政企数据中心的AI服务器采购清单,凭借本土化的技术支持和快速的产品迭代,成为国产GPU领域的重要参与者。值得注意的是,通用GPU的应用场景不仅限于AI服务器,还能延伸至工业设计、数字渲染等领域,这为摩尔线程打开了更广阔的市场空间。

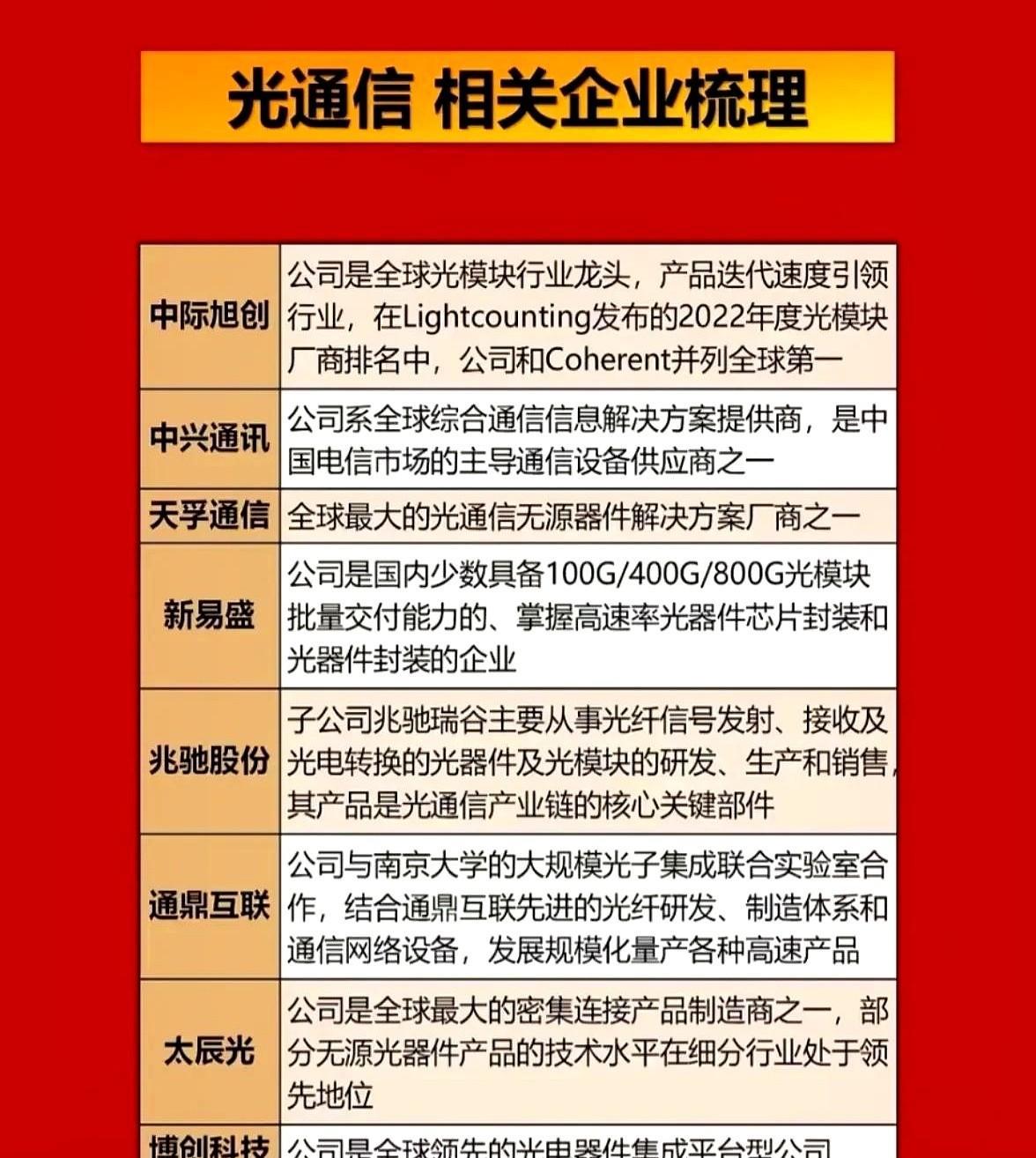

三、光模块与光芯片:数据传输的“高速桥梁”,国产替代进入加速期

AI服务器集群的海量数据传输,需要高带宽、低延迟的通信链路,光模块与光芯片正是构建这一链路的核心。其中,光模块负责将电信号转换为光信号,光芯片则是光模块的核心元器件,二者的技术水平直接影响数据传输的效率。

在光模块领域,中际旭创的800G光模块全球市场占有率超30%,1.6T光模块已完成客户测试并实现小批量供货,其产品被亚马逊、微软等海外云厂商用于AI数据中心建设。光迅科技则实现了从光芯片到光模块的垂直整合,其自主研发的光芯片占自身光模块用料的60%以上,这不仅降低了生产成本,还提升了产品的供货稳定性。新易盛的800G光模块产能在2024年提升至每月50万只,天孚通信的光器件产品在高速光模块中的配套率超80%,二者成为光模块赛道的中坚力量。

光芯片是光模块的“卡脖子”环节,此前海外企业占据全球90%以上的市场份额。源杰科技的25G激光芯片已实现批量供货,产品性能达到国际同类产品水平,2024年其光芯片的出货量占国内市场的35%。长光华芯在高功率光芯片领域的研发成果,则为光模块向更高速率升级提供了技术支持,其100G光芯片已完成实验室验证,预计2025年实现商用。随着光芯片国产替代的推进,国内光模块企业的成本优势将进一步凸显。

四、PCB:AI服务器的“硬件载体”,高端产品需求迎来爆发

PCB(印制电路板)是AI服务器的基础硬件载体,负责连接所有电子元器件。与普通服务器不同,AI服务器的PCB需要满足高集成度、高散热性、高抗干扰性的要求,这对PCB企业的生产工艺提出了严苛标准。

胜宏科技在高端PCB领域的技术实力突出,其生产的高多层PCB产品层数可达40层以上,能满足AI服务器复杂的电路设计需求,2024年上半年其AI服务器用PCB的营收占比提升至45%。沪电股份则专注于数据中心PCB的研发,其为AI服务器定制的PCB产品在散热设计上采用了埋铜工艺,能有效降低服务器运行时的温度,成为浪潮、华为等服务器厂商的核心供应商。深南电路的高频高速PCB、生益科技的PCB基材、东山精密的精密结构件,共同构成了国产AI服务器PCB的供应链体系,随着AI服务器出货量的增长,这些企业的高端PCB产品订单将持续增加。

五、存储:AI服务器的“数据仓库”,国产产品逐步实现进口替代

AI大模型的训练和推理需要处理海量数据,这要求AI服务器具备大容量、高速度的存储能力。存储组件主要包括内存接口芯片、固态硬盘、闪存芯片等,其性能直接影响数据的读取和写入效率。

澜起科技在内存接口芯片领域的全球市场占有率超40%,其研发的DDR5内存接口芯片能将内存的传输速率提升至6400MT/s以上,是AI服务器存储系统的核心配件。2024年,澜起科技的内存接口芯片出货量同比增长50%,受益于AI服务器对高带宽内存的需求,其产品的市场份额有望进一步提升。江波龙的工业级固态硬盘在AI服务器中的应用占比持续提升,其产品的读写速度可达7GB/s,能满足大模型数据处理的需求。德明利、佰维存储从消费级存储向工业级存储转型,兆易创新的闪存芯片、北京君正的存储控制芯片也实现了在国产AI服务器中的批量应用,国产存储产品的市场份额已从2023年的15%提升至2024年的30%。

六、CPU:AI服务器的“运算中枢”,自主架构成为发展主流

CPU是AI服务器的运算中枢,负责统筹协调各个组件的工作,与算力芯片协同完成AI运算任务。此前,国内AI服务器的CPU主要依赖英特尔、AMD等海外企业的产品,自主可控性较低。

海光信息的CPU基于x86架构研发,其产品的性能与英特尔同级别产品相当,2024年上半年海光CPU的出货量同比增长300%,已应用于国内政企数据中心的AI服务器中。龙芯中科则坚持自主研发的LoongArch架构,其龙芯3A6000CPU的性能达到国际主流水平,在安全性和自主可控性上具备独特优势,适合对国产化要求较高的政务、军工等领域的AI服务器场景。随着国内对信息技术自主可控的要求不断提升,海光信息和龙芯中科的CPU产品将成为国产AI服务器的核心选择。

七、液冷:AI服务器的“散热方案”,高算力下的刚需技术

AI服务器在高负荷运行时会产生大量热量,传统的风冷散热效率已无法满足需求,液冷散热凭借更高的散热效率,成为AI服务器的标配技术。目前,液冷散热主要分为冷板式液冷和浸没式液冷两种,其中浸没式液冷的散热效率是风冷的10倍以上。

英维克是国内液冷散热领域的龙头企业,其浸没式液冷方案已应用于腾讯、阿里的AI数据中心,能将AI服务器的能耗降低30%以上。2024年,英维克的液冷产品营收同比增长200%,订单排期已至2025年。中石科技研发的导热凝胶、相变材料等散热材料,能提升液冷系统的散热效率;飞荣达生产的液冷散热结构件,为液冷系统提供了稳定的物理支撑;思泉新材在液冷散热新材料领域的突破,让液冷系统的成本降低了20%。随着AI服务器算力密度的不断提升,液冷散热的市场需求将呈现爆发式增长,相关企业的发展前景值得期待。

-

结语:

AI服务器产业链是AI产业发展的“基石”,七大细分领域的国产企业正通过技术突破,逐步打破海外企业的垄断。从算力芯片的商用落地,到液冷散热的规模化应用,国内企业在这条赛道上的进步有目共睹。

那么,在你看来,AI服务器产业链中哪个细分领域的国产替代速度会最快?又有哪些企业能凭借技术优势成为全球市场的领导者?欢迎在评论区留下你的观点,一起探讨这条硬核赛道的未来发展。

我是桃夭夭,持续为您分享最新财经消息,记得点个关注!

温馨提示:所有观点均是个人投资心得体会,和个人身边真实案例分享,供大家交流讨论,不涉及任何投资建议,请大家别盲目跟风,盈亏自负!成年人要有自己的判断。