路口掉头避开斑马线、左转减速礼让行人、路遇前方车辆掉头防御性减速...你以为这些操作都出自经验丰富的老司机?但这却是乐道即将发布的Coconut 2.1.0端到端智驾系统交出的“答卷”。通过“端到端”大模型技术,智能驾驶系统以接近人类直觉的方式,“理解”并应对城区复杂路况,而非仅仅“识别”和“反应”。

在智能驾驶领域,“长尾问题”是阻碍城区应用的最大梦魇——那些发生概率极低但种类无限的道路场景,如特殊车辆、怪异障碍物、非常规交通行为等。传统基于规则和模块拼接的方案,如同试图为每一种可能的意外编写应急预案,注定顾此失彼。

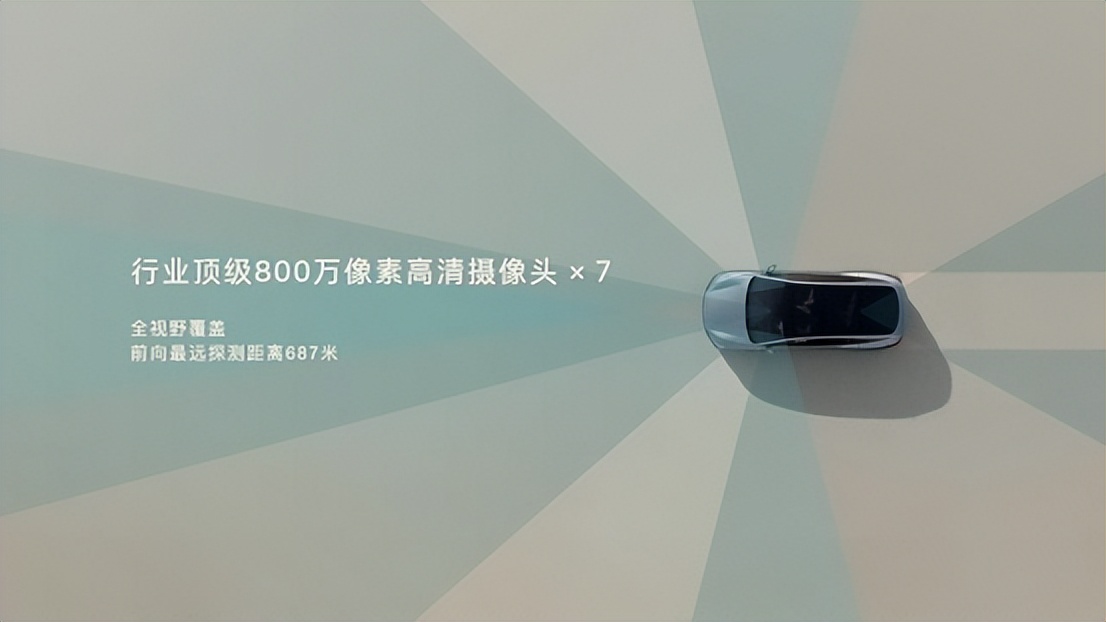

乐道Coconut 2.1.0所依托的“端到端”技术,其革命性在于从根本上改变了系统的“思维方式”。它不再依赖“感知-预测-规划-控制”的线性链条,而是用一个统一的深度神经网络,直接学习从传感器原始数据(摄像头视频流)到车辆控制信号(方向盘、油门、刹车)的映射关系。这好比从一个需要逐条查阅交规手册的新手,进化为一个凭借丰富驾驶经验形成“车感”的老司机。在面对数据库里未曾明确收录的“长尾场景”时,系统不再“茫然”,而是能基于对相似场景规律的理解,做出更合理、更连贯的泛化决策。

乐道此举,将对行业产生涟漪效应。首先,它重新定义了“全场景智能驾驶”的内涵。过去,“全场景”往往指地理范围的覆盖。而基于端到端的“全场景”,更强调对无限“长尾”场景的通用处理能力。这迫使其他玩家必须重新评估自身技术路径的长期有效性。

其次,它可能加速高级别自动驾驶商业化的时间表预期。尽管完全的无人驾驶(L4/L5)仍前路漫漫,但随着科技的进步、大数据不断完善更新,覆盖范围更广、体验更连贯的高阶辅助驾驶(L2+/L3),其普及速度可能会超出预期。

乐道Coconut 2.1.0的推出,不仅意味着其纯视觉路线通过了关键一役,更预示着智能驾驶竞争的下半场,将从“传感器军备竞赛”,更深层次地转向“算法与数据效率”的终极较量。