如果告诉你,科学家正计划把庞大的数据中心发射到太空,让人工智能在轨道上运转,你会作何感想?这听起来像科幻电影的疯狂构想,却是Google Research真实推进的项目。当地球上的AI服务器每天吞噬着惊人的电力和水资源时,有人想出了一个极端方案——既然地球承受不住,那就搬到太空去。但这真的可行吗?为什么有专家直言"把服务器送上轨道是个愚蠢的主意"?这场关于未来计算基础设施的激烈争论,正揭示着人类与AI共存的深层困境。

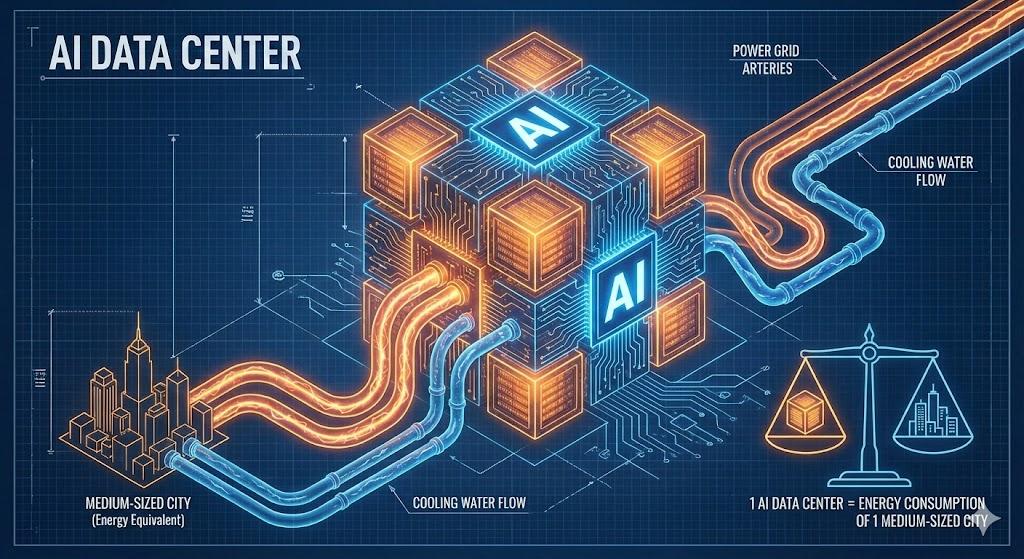

我们都知道,每次你和ChatGPT对话、生成一张AI图片、训练一个模型,背后都有巨大的服务器在运转。但很少有人意识到这个规模有多惊人:到2030年,全球数据中心的电力消耗可能占据总发电量的8-10%。

想象一下,一座大型AI数据中心的耗电量相当于一个中型城市。更可怕的是冷却系统——这些高性能芯片运行时产生的热量,需要消耗海量的水资源和电力来降温。一个典型的数据中心每天用水量可达数百万升,相当于几千个家庭的用水总和。

问题在于:随着AI模型越来越大(从GPT-3的1750亿参数到更大规模的模型),这种需求呈指数级增长。传统的解决方案——建更多数据中心、扩大电网容量——只是在延缓危机到来的时间。这迫使科学家们思考:我们能否跳出地球的限制?

在深入太空方案之前,必须理解数据中心的能耗困境。数据中心本质上是成千上万台服务器的集合体,每台服务器配备着高性能处理器和AI加速器(如GPU、TPU),它们24小时不间断运行。

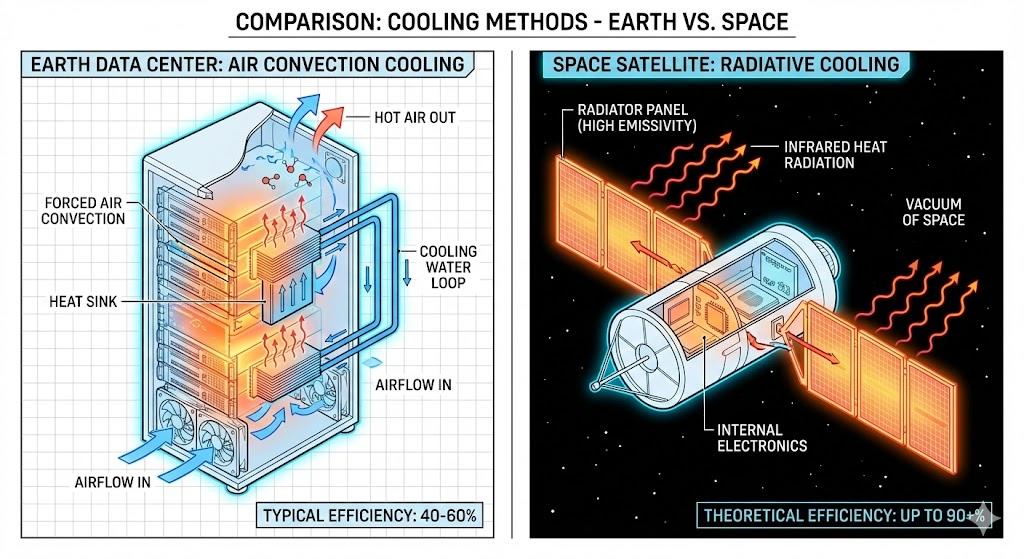

能耗的两大杀手分别是计算本身的电力消耗和冷却系统的能耗。现代AI芯片功率可达300-700瓦,一个机架装几十块芯片,耗电量惊人。而这些芯片运行时温度可达80-90°C,必须依靠复杂的水冷系统或空调设备降温。令人震惊的是,冷却系统的能耗往往占数据中心总能耗的40%。

传统方式采用"风冷+水冷"组合:巨大的风扇吹过装满冷水的管道,带走热量。但这在物理上效率极低——空气传热能力差,水资源又稀缺。就像用电风扇给烧红的铁块降温,费力不讨好。

2024年,Google Research提出了震惊业界的Project Suncatcher(捕日计划):在近地轨道部署携带AI加速器的卫星阵列,利用太空环境的独特优势运行数据中心。

这个方案的核心逻辑听起来很美好。首先是持续的太阳能供给:在太阳同步轨道上,卫星可以24小时接收阳光,不受昼夜、天气、季节影响。太阳能板的发电效率比地面高30-40%,因为没有大气层削弱光照。其次是真空散热的天然优势:太空是近乎完美的真空环境,热量只能通过辐射方式散发(就像你感受到太阳的温暖,但中间没有空气传递)。理论上,高温芯片可以直接向宇宙"辐射"热量,无需水冷或风扇,效率远超地面。最后是零污染零占地:不消耗地球淡水,不产生碳排放,不占用土地资源。

听起来完美无缺?别急,反对者正准备好一箩筐致命问题。

支持者描绘的太空优势,在物理现实面前充满挑战。

虽然真空中可以辐射散热,但辐射散热效率远低于对流散热。在地球上,风扇加水冷可以快速带走热量;在太空中,芯片产生的热量只能缓慢地以红外线形式辐射出去。这就像:地面是用水管冲洗热锅,太空是让热锅自己"凉"下来。

为了提高散热效率,卫星需要配备巨大的辐射散热板(类似国际空间站的太阳能板那样大),这会大幅增加重量和成本。更麻烦的是,在阳光直射的轨道面,卫星还会持续"被加热",散热变得更加困难。这种矛盾就像在烤箱里放冰块——你既想让它冷却,环境却在不断给它加热。

确实,太空太阳能充足,但AI计算需要的是稳定、高功率的电力。太阳能板受制于光照角度、太阳活动周期,输出功率会波动。而AI训练任务可能需要连续运行数周,任何电力中断都是灾难。

这需要配备巨大的储能电池系统(用于卫星经过地球阴影区时供电),进一步增加重量。你可以想象成:带着一座移动发电站和备用电源库上太空。

专家们的批评直指要害,可以归结为三大无解难题。

硬件如何维护?地面数据中心可以随时派工程师更换故障硬件、升级芯片。但太空服务器一旦出问题,维修成本是天文数字。发射一次太空任务的费用数千万美元起步,而芯片故障率在高辐射环境下会显著上升(宇宙射线会损坏电路)。

更现实的问题是:AI芯片的迭代周期约18-24个月。当新一代GPU性能翻倍时,天上的旧硬件怎么办?报废?回收?每次升级都要重新发射?这在经济上根本不成立。就像买了辆汽车却永远无法换轮胎,只能扔掉重买。

网络延迟的死结同样致命。光速是宇宙的速度极限,这意味着地球到近地轨道(约400公里)的通信延迟至少2.7毫秒(往返)。如果考虑信号处理、数据传输,实际延迟可能达到10-50毫秒。

对搜索引擎、实时聊天、自动驾驶等应用,这是无法接受的。你问ChatGPT一个问题,光等待信号上天下地就要几十毫秒,用户体验会崩溃。唯一适合的只有"离线批处理任务"(如科学计算、模型预训练),但这类需求占AI总算力的不到20%。

**成本是否划算?**这是核心障碍。即使SpaceX的猎鹰9号将发射费用降到约每公斤2700美元,部署一个10吨的小型太空数据中心仍需2700万美元,还不包括研发、保险、运维费用。而这笔钱在地面可以建设一座先进的绿色数据中心,配备可再生能源和高效冷却系统。

反对者讽刺道:"把服务器扔到太空,就像为了省电费把冰箱搬到南极——理论上可行,实际上荒谬。"

尽管批评声浪高涨,但支持者指出了几个被忽视的潜在价值。

如果人类在2030年代建立月球永久基地,月球与地球的通信延迟约2.6秒(往返)。此时,在月球轨道部署数据中心就变得合理——它可以就近为月球科研站提供算力,延迟远低于地月通信。这不再是解决地球问题的方案,而是支撑太空探索的基础设施。

某些AI任务本身不需要实时响应。比如气候模型计算需要运行数月的长期模拟,大规模模型预训练(训练GPT-5可能需要数周),天文数据处理要分析射电望远镜捕获的海量信号。这些任务可以利用太空的能源优势,而不受延迟影响。就像邮寄包裹——虽然慢,但能装更多东西。

更具前瞻性的场景是:当太空采矿、轨道制造成为现实,就地利用太空资源建设基础设施可能比从地球发射更经济。例如,用月球土壤3D打印辐射屏蔽层,用小行星金属制造散热板。此时,太空数据中心才能真正发挥优势。

不可思议的是,这些场景并非空想——NASA的Artemis计划、中国的月球科研站计划都在推进中。太空数据中心可能不是解决今天问题的答案,但可能是2040年代太空基础设施的一部分。

现行的《外层空间条约》(1967年)规定太空属于"全人类共同财产",但对商业基础设施的产权、责任归属模糊不清。如果一颗数据中心卫星故障坠落,造成地面损失,谁来赔偿?如果黑客攻击太空服务器,如何追责?这些问题在地球上已有法律框架,但在太空却是一片灰色地带。

近地轨道的"轨道位置"和"无线电频谱"是有限资源。当前已有数万颗卫星(含星链等星座),太空交通管理已成难题。大规模部署数据中心卫星,可能加剧轨道拥堵和太空垃圾问题。想象一下高速公路上突然增加几千辆大卡车——拥堵和事故风险都会飙升。

更敏感的是数据主权困境。如果你的数据存储在轨道上,它属于哪个国家管辖?美国政府能否要求Google交出存储在太空的用户数据?这涉及《云法案》等跨国数据监管的灰色地带,可能引发新一轮的科技冷战。

正如国际空间法专家所说:"太空数据中心不仅是工程问题,更是治理难题。在规则建立之前,任何大规模部署都是冒险。"

太空数据中心的争论,本质上折射出一个更深层的问题:当AI的能耗需求与地球承载力产生根本冲突时,我们该选择约束技术,还是突破行星边界?

目前,Project Suncatcher仍处于概念验证阶段,最乐观估计也要到2035年后才可能有实际部署。但这场辩论已经开始:SpaceX在测试轨道数据中心原型,中国航天科技集团在研究太空信息基础设施,欧洲航天局在评估月球数据中心的可行性。各方都在押注一个可能性——也许在我们有生之年,"云端"这个词会从隐喻变成字面意义。