近期,液冷方向不断走强,甚至让人有一种超越光模块、高端PCB的感觉。

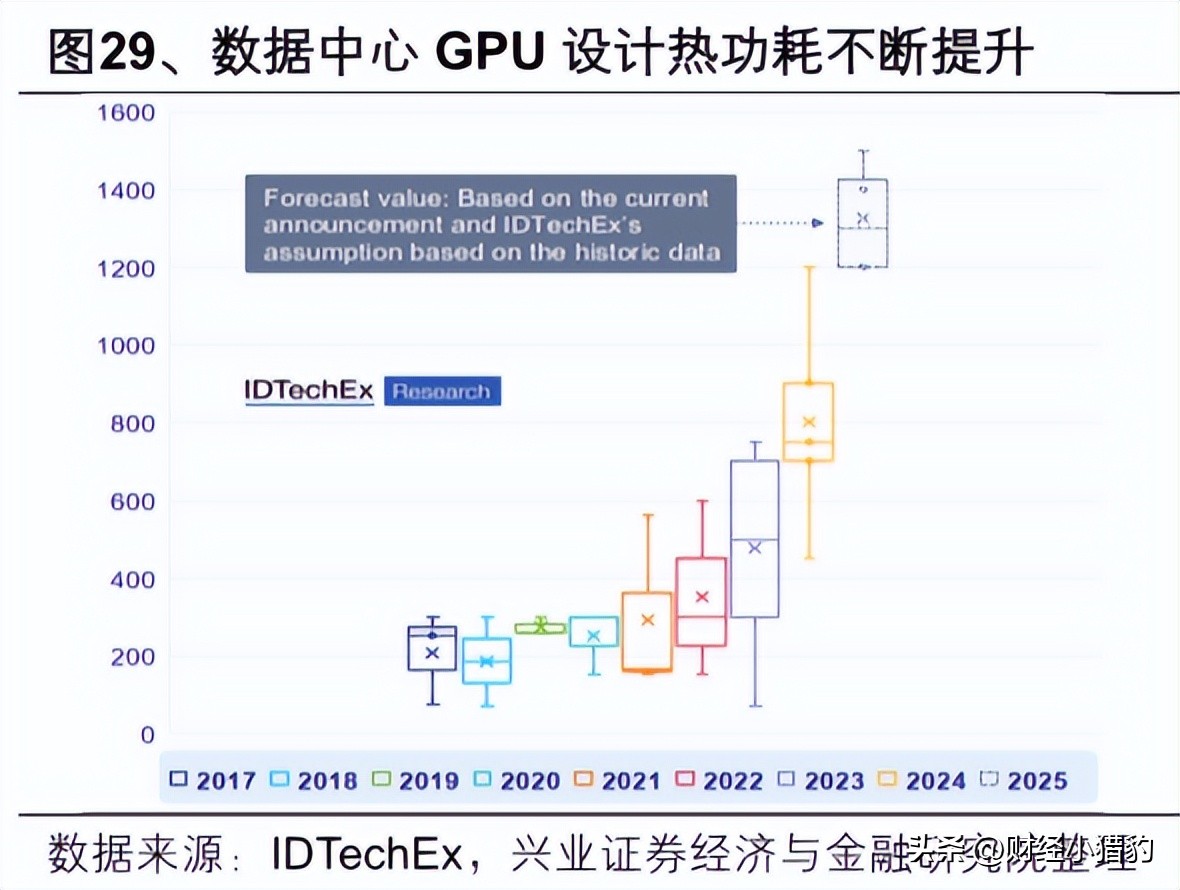

其实目前大模型训练集群规模突破万卡、单机柜功耗跃升至百千瓦级,一个更底层、更刚性的瓶颈正在浮出水面:散热能力,已成为制约算力释放的物理天花板。

而液冷,正从可选配套加速蜕变为AI数据中心的“默认配置”。

从这方面来看,这一点跟光模块逻辑差不多,就是芯片功率越高,算力更强,那就需要更好的光链接,这也就是为什么要从800G,到1.6T,而这个方面就也会带来液冷的需求。

当前主流AI服务器平台(如NVIDIA GB200 NVL72)整柜功耗已达120kW,热流密度超过5kW/U。

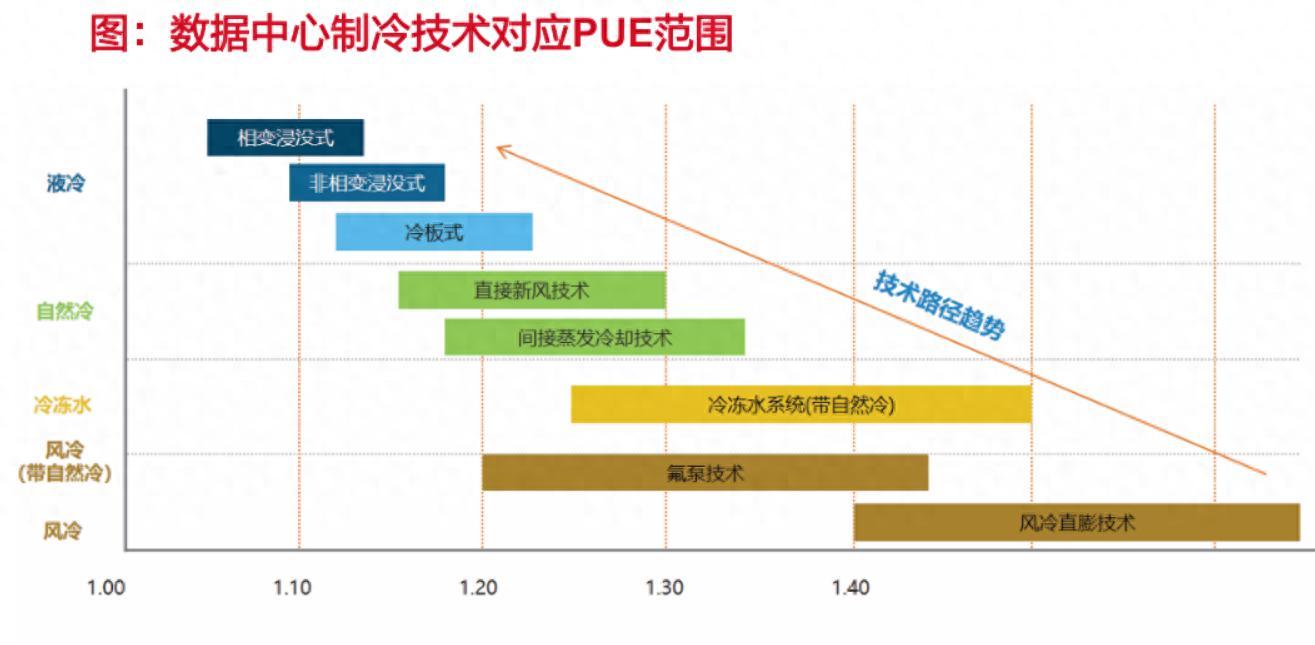

而传统风冷架构的工程极限仅为20–30kW/柜——再往上,需指数级增加风扇数量、风压与冗余空间,导致PUE(能源使用效率)急剧恶化。

据MIT 2024年研究,当单芯片功耗突破700W,风冷系统的PUE将劣化至1.4以上,远高于液冷的1.05–1.1。

更关键的是,风冷无法随算力线性扩展。

每提升10kW功耗,风道设计、结构强度、噪音控制都面临非线性成本跃升。

而液冷通过直接接触芯片(冷板式)或全浸没冷却,热传导效率提升10–50倍,且PUE几乎不随负载变化。

这意味着:在万卡级AI集群中,不用液冷=无法稳定交付高密度算力。

这方面也可以全球头部云厂商动作来验证,谷歌、Meta等在其最新AI训练集群中全面采用液冷,并测算“若用风冷,需额外增加40%机房面积”,微软Azure则要求2025年起所有>50kW机柜必须预留液冷接口。

液冷的经济性拐点或已现

液冷的经济性拐点或已现过去液冷被视作“奢侈品”,因其初期CAPEX显著高于风冷。

但全生命周期视角下,逻辑正在反转:

根据市场机构测算,单AI机柜液冷方案成本约5–10万美元,为风冷的5–15倍;

但液冷可节省30–40%机房面积、降低25–30%电力消耗、减少50%以上运维人力;

更重要的是,GPU因温控稳定可持续满频运行,算力利用率提升15%,直接放大单位投资回报。

比如以一个10MW AI智算中心为例,液冷方案前期多投入约3000万,但5年带来的其他收益加起来反而出现经济性拐点。

渗透率加速方面,2023年液冷在AI服务器渗透率不足5%。

2024年Q2起,国内头部云厂商新建智算中心液冷比例已超25%。

2025年Q3其,全球头部云厂商新建智算中心液冷比例已超40%。

IDC预测,2026年全球AI服务器液冷渗透率将达35%–50%,对应市场规模从2023年的8亿美元飙升至50亿美元以上,三年复合增速超80%。

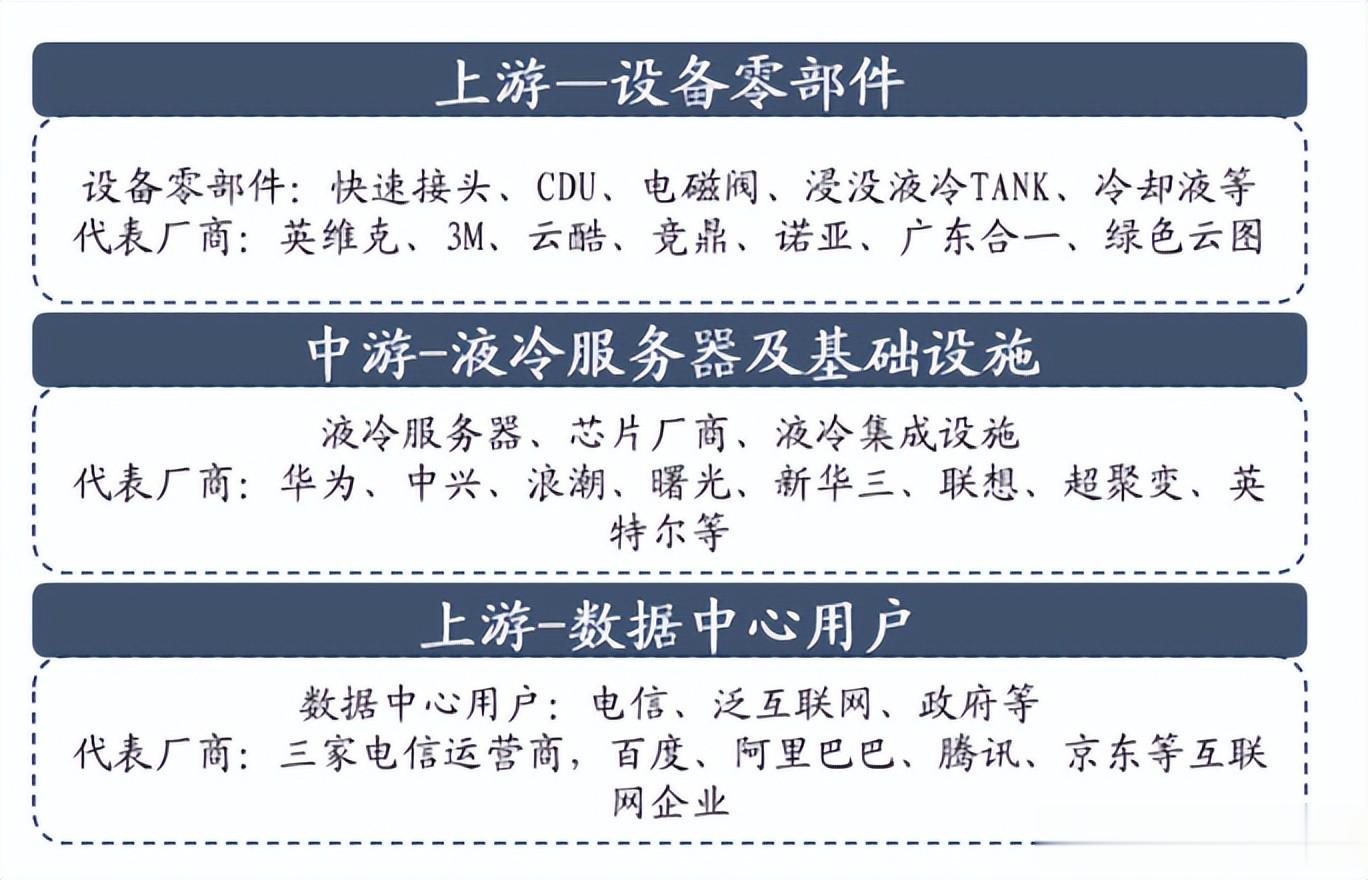

哪些方向可能受益大家要知道,液冷并非单一产品,而是一套高度集成的热管理系统。

其产业链可划分为三大层级,各具不同的技术壁垒、价值量分布与国产化节奏:

上游:高壁垒材料与核心部件

冷却液:尤其是用于浸没式的电子氟化液,占整套系统成本近40–60%,目前国产高纯氟化液、硅油等正快速验证,具备显著成本优势。

微通道冷板:直接贴合GPU/CPU,需精密蚀刻与焊接工艺,单块价值数百美元,是冷板式液冷的核心部件。

泵阀与快插接头:要求零泄漏、耐腐蚀、高频插拔,技术门槛高,但国产厂商已在中低压场景实现突破。

中游:系统集成与模块化方案

CDU(冷却分配单元):作为液冷系统的“心脏”,集成换热器、水泵、控制器,占整柜价值30%以上。其智能化程度(如流量自适应调节、漏液预警)决定系统可靠性。

液冷机柜/Tank:尤其在浸没式方案中,需高密封性、耐腐蚀、承压设计,正向标准化模块演进。

下游:应用场景拓展

AI智算中心:当前最大需求来源,单项目规模或许可达数十亿元。

超算与科研装置:对PUE<1.1有硬性要求,天然适配浸没式液冷。

边缘计算节点、5G基站、储能系统、新能源车电驱:虽单点价值较低,但部署分散、总量庞大,将成为第二增长曲线。

写在最后如果说光模块是AI的“神经”,那么液冷就是它的“循环系统”,看不见,但或者至关重要。

当AI集群迈入“百兆瓦级”时代,谁掌握高效热管理能力,或许就会影响算力运行的能力。

这方面来看,液冷或许值得我们持续跟踪。

特别声明:以上内容绝不构成任何投资建议、引导或承诺,仅供学术研讨。

如果觉得资料有用,希望各位能够多多支持,您一次点赞、一次转发、随手分享,都是笔者坚持的动力~