导读

亚马逊在 re:Invent 上官宣第三代自研 AI 加速器 Trainium3,并同步推出基于该芯片的 Amazon EC2 Trn3 UltraServer 系统。官方口径:系统级最高可达 4.4× 计算性能提升、4× 性能/瓦提升,且单机可容纳多达 144 颗 Trainium3 芯片,是 AWS 首款 3nm AI 芯片组合。

单颗 Trainium3 芯片提供 2.52 PFLOPs(FP8)算力,HBM3e 容量 144GB,较上代分别在容量与带宽上提升 1.5× 与 1.7×;在 Amazon Bedrock 上,Trainium3 被称为“最快加速器”,相较 Trainium2 最高可达 3× 性能,输出 tokens 吞吐也显著提升。

媒体与第三方报道补充:系统与芯片在能效方面也有约 40% 的改进说法,同时 AWS 公开表示将推进与英伟达生态更友好的互通路线图(Trainium4 将支持与 NVLink 相关的协同),显示其在开放性与性价比上双线推进。

本文从“规格与系统”“为何重要:性能/瓦与内存带宽”“规模化与生态”“谁该上车与何时上车”四条主线,拆解 Trainium3 的技术与商业意义。

正式发布:Trainium3 与基于其的 Amazon EC2 Trn3 UltraServer 在 re:Invent 期间亮相并开始向客户开放,AWS 称其是面向大模型训练与高负载推理的系统级升级。

定位关键词:

更高的系统级算力密度(单机 144 芯片);

显著的性能/瓦(Perf/W)改进(官方口径 4×,媒体口径亦提及 ~40% 级别优化的表述,语境不同,口径略有差异)。

背景:GPU 供需持续紧张与能耗上限渐成约束,云厂商自研加速器的目标从“追性能”向“算力密度与 TCO”转移。Trainium3 的所有改动几乎都围绕这两点展开。

项目Trainium3(芯片/系统)与 Trainium2 对比(相对值)主要来源制程工艺3nm(AWS 首款 3nm AI 芯片)—About Amazon、AWS 博客单芯片 FP8 算力2.52 PFLOPs(FP8)—AWS What's New单芯片内存HBM3e 144GB容量 +1.5×、带宽 +1.7×(相对 Trn2)AWS What's New单机系统规模(Trn3 UltraServer)最多 144 颗芯片/台—About Amazon系统级性能提升最高 4.4×(相对 Trn2 系统)Perf/W 4× 提升About Amazon、AWS 博客Bedrock 实测/宣称Trainium3 为平台最快加速器对 Trn2 最高 3× 性能、输出 tokens 吞吐 5×+AWS Trainium 页面、What's New供货与可用性Trn3 UltraServer 已向客户开放、将快速扩容—BusinessWire、About Amazon Live媒体补充口径(能效)—系统/芯片层面约 40% 能效改进的表述TechCrunch

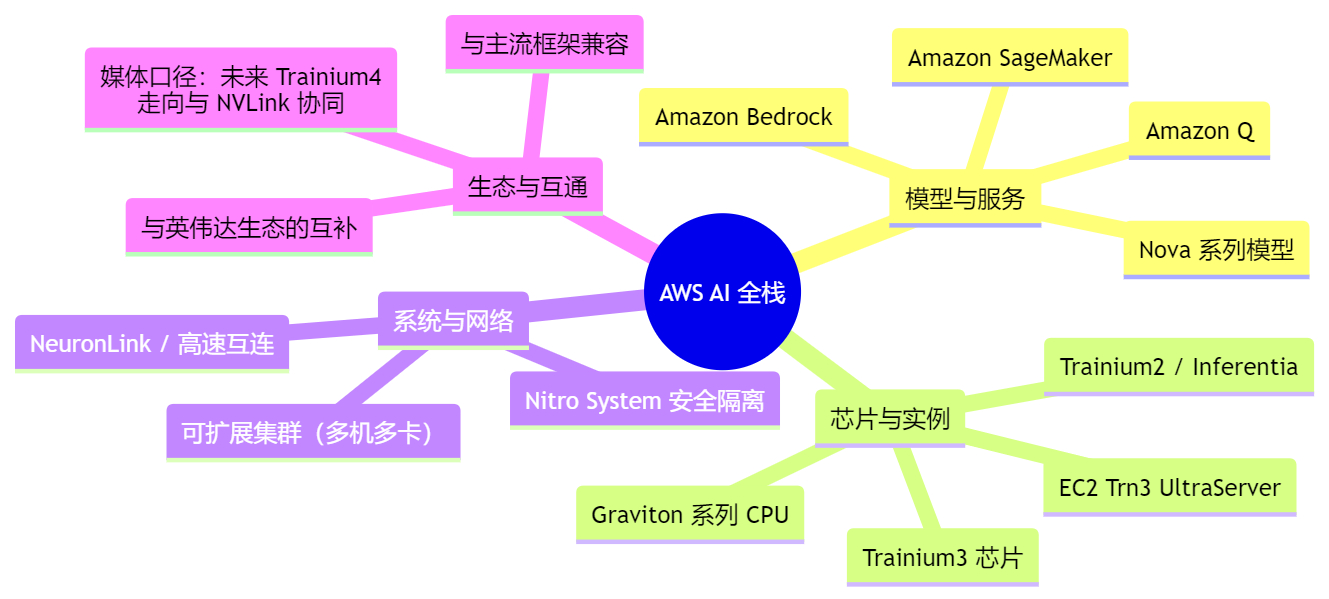

AWS 从“芯片—系统—软件—模型”的垂直整合,指向更高的算力密度与更优 TCO

二、为何重要:Perf/W、内存带宽与“训练—推理”两端的真实收益性能/瓦的核心意义

对训练:更高的 Perf/W 意味着以相同电力预算获得更多有效算力,缩短总训练时长(wall-clock time),进而降低每轮实验的机会成本与资金成本。在受电力与上架密度约束的数据中心,这一点直接决定同一机房能“塞下”多少可用训练算力[1]。

对推理:可把“每 100 万 tokens 成本”打下来。Bedrock 场景下对“输出 tokens 吞吐”的提升,等价于在高并发时段抬升系统峰值产出,缓解排队、降低尾延迟与超时率[2][3]。

内存容量与带宽的现实约束

144GB HBM3e/芯片与 1.7× 带宽提升,瞄准的是“参数—激活—KV Cache”三重内存墙:

·训练时的激活检查点/张量并行跨节点通信;

·推理时的 KV Cache 驻留,直接影响并发与长上下文吞吐;

·更高带宽在 MoE/检索增强生成(RAG)等稀疏访问场景中同样关键[3]。

系统级整合的边际收益

单机 144 颗的 UltraServer 带来的不是线性堆叠,而是减少跨机房/跨机架通信开销的“集群内局部性”收益,对流水线并行和大规模张量并行尤为重要。官方宣称系统级最高 4.4× 性能提升,背后即是“芯片—板卡—背板—互连”的耦合优化。

三、规模化与生态:AWS 的“开放+自研”双轮规模化:AWS 表示 Trn3 UltraServer 已经在部分数据中心可用,并计划快速扩容。对大模型训练而言,真正的门槛不是“单卡性能”而是“可用集群规模×可用时长”。越早实现规模化供给,越能把训练队列与交付周期压短。

生态与互通:

·Bedrock 场景下,Trainium3 被定位为“最快加速器”,同时 AWS 也公开与英伟达技术的协作路线,媒体称下一代 Trainium4 将与 NVLink 技术协同,指向“可在同一经济机架内兼顾 GPU 与自研加速器”的混部形态。

·对客户的含义:短期内,你并不需要“二选一”。更现实的策略是以任务特征做异构分层:训练用 Trn3/高能效集群,某些算子/框架最优解留在 GPU,推理侧按延迟与吞吐需求分配在不同池化资源上。

对产业的启发:云厂商自研加速器不一定取代 GPU,但可以在“供给规模与 TCO”上形成强互补,驱动整体云端 AI 成本曲线下移。

四、与“友商”的相对位势:别把问题只化约为“峰值 FLOPs”与英伟达:GPU 在生态、工具链与开发者基数上的优势仍然稳固,但 Trainium3 把“Perf/W×供给规模×系统整合”这条曲线拉高。对成本敏感且能适配 Neuron 工具链的客户,迁移动机被显著增强;对必须依赖特定 CUDA 内核与框架插件的工作负载,GPU 仍是主力。AWS 在公开叙事中也强调互补,这是理性的市场策略。

与 Google TPU:二者均走“专用化+系统级耦合”的路线。Trainium3 的看点在于单机 144 颗的整合度与 Bedrock 平台的即插即用,而 TPU 的优势仍在于 Google 自家大模型生产实践的深度绑定。对外部客户而言,选择标准将更多回到“可得性、工具链与全链路 TCO”。

别把比较简化成“谁的 TOPS 更大”。对绝大多数企业,能否得到成规模、可预订、能持续扩容且工具链成熟的算力,往往决定 ROI 上限。Trainium3 把这三件事做成了一个系统级产品。

五、谁该上车,何时上车:给 CTO 的三条决策线任务画像法:

大模型训练(>百亿参数,混合并行):优先试用 Trn3 UltraServer。关注跨节点通信开销、流水线并行效率与 Checkpoint/恢复策略能否在 Neuron 工具链下稳定跑通。

高负载推理(多租户、长上下文):重视“输出 tokens 吞吐”的改进,评估 KV Cache 策略与批处理调度。对峰值并发业务,Perf/W 的提升可直接摊薄每百万 tokens 成本。

多框架混部(部分 CUDA 生态强依赖):采用“GPU + Trn3”的异构池化,按算子/延迟目标拆分路由,避免一次性全量迁移的风险。

迁移与试点路径:

先在 Bedrock 上跑通端到端链路(数据→训练→评估→推理→观测),用小集群验证吞吐、时延与稳定性,再扩大规模;

关注成本度量口径统一(训练:每有效 step 成本;推理:每百万 tokens 成本),以便横向比较 GPU 与 Trn3。

六、仍待确认的关键信息价格与计费结构:官方尚未披露详细的实例定价与跨可用区带宽费用;需要以区域价目表与合同条款为准。

开发者生态:部分长尾算子、定制 kernel 与框架插件在 Neuron 工具链的成熟度与性能曲线;需要结合团队代码栈实测。

规模可用性:你所在区域的数据中心上架节奏、可预约的集群规模与时段配额(等待队列)。

性能口径:官方“4.4×/4×”为系统相对 Trn2 的对比口径;媒体“~40% 能效改进”来自不同语境的报道,需以目标工作负载的实测为准。

Trainium3 不是一颗“更快”的芯片那么简单,而是 AWS 把“更高算力密度、更优 Perf/W、更顺手的平台集成”打包成了一台可订购的系统。对正在为算力成本与供给发愁的团队,它提供了一条现实且可行的“性价比路线”。短期看,它会把云端 AI 的训练与推理 TCO 再压一轮;中期看,随着与 GPU 的互通增强,企业将以任务特征在多类加速器之间做更细粒度的资源路由,算力将真正“按场景计费”。