做电影解说三年,发现一个规律:

80%的人在配音环节浪费了超过50%的时间,最后效果还不如预期。

常见困境:试了七八个AI音色,每个都觉得"差点意思";自己录音,录了二十遍还是不满意;最后得出结论——"配音太难了"。

问题根源不在于"不会选工具",而在于:大多数人根本没搞清楚电影解说配音的"合格线"到底是什么。

一、电影解说配音:90%的"出戏"不是音色问题一个反直觉的事实:那些播放量百万级的电影解说,很多声音并不惊艳,甚至有些"平淡"。但观众看得下去,完播率很高。

因为电影解说配音的核心标准,从来不是"声音好不好听",而是"声音有没有干扰内容传达"。

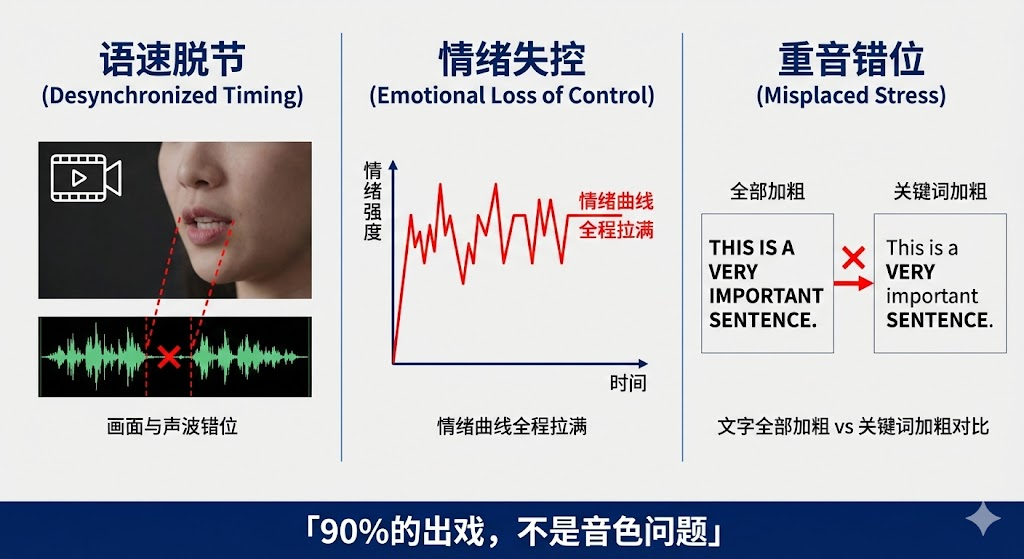

真正导致"出戏"的三个问题问题一:语速和画面节奏脱节

画面还在铺垫,配音已经"高潮";镜头切了,上一句还没说完。本质是配音和剪辑两套系统各干各的。

问题二:情绪强度和剧情密度不匹配

普通过渡剧情全程激情解说,真正高潮点情绪反而上不去。电影解说的情绪分配应该像理财——额度有限,开头花光了,后面再加码观众也麻木。

问题三:信息重音放错位置

所有词重音一致,像在念课文。因果、转折、关键信息没有被"点出来",观众听完抓不住重点。

这三点,才是绝大多数"出戏感"的真正来源。

适合的三种情况:

强个人IP型账号(声音是记忆点)

低频高质量更新(一周1-2条,允许反复调整)

第一人称强主观表达(情绪本身是内容核心)

常见翻车点:

嗓音状态不稳定,今天好明天哑

情绪过度参与,反而干扰叙事

为了"自然"牺牲了信息清晰度

结论:真人配音上限高,但对新手来说失败概率也高。

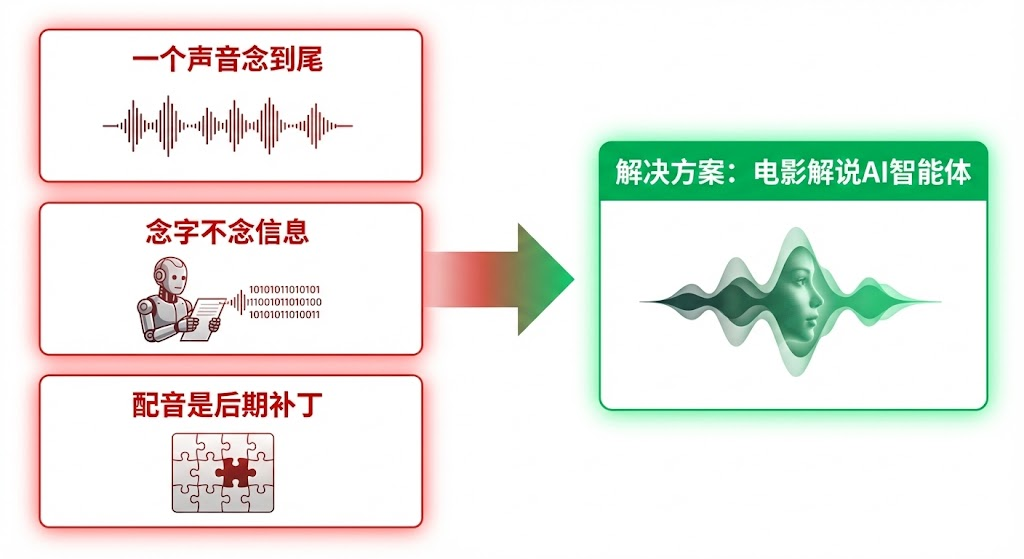

AI配音:被误解最深的工具很多人说AI配音"假",但拆解后会发现,这个"假"是三个技术缺陷叠加的结果——2026年这三点都有成熟解决方案。

三、AI配音"假"的三个根源及解决方案根源一:一个声音从头念到尾问题本质:电影解说包含叙事、角色、情绪三种声音功能,但大多数AI工具的逻辑是"一段文本=一个声音=一种语气"。

解决方案: 在脚本阶段拆分声音层级,为不同功能分配不同声音策略。

根源二:AI在念字,不是在说信息问题本质: AI不知道哪句是重点、哪句该停顿、哪个词需要强调。整段文本丢进去,只能线性朗读。

解决方案: 文本必须被拆成"语义块"——信息句稳定压低情绪,转折句微停顿,强调句重音落在关键词。

根源三:配音永远是后期补丁问题本质: 大多数人的流程是"剪完画面→贴声音→强行对齐",配音是剪辑后的"外来者"。

结果就是:画面切了话没说完,话说完了镜头还在拖,情绪刚起来画面已经切走。观众感受到的不是"AI假",而是音画逻辑不一致。

解决方案: 让配音进入剪辑逻辑本身。

优点: 国内用户基数最大,和剪辑无缝衔接,上手零门槛,基础AI配音免费。

缺点: 不是为解说场景专门设计,语义理解能力有限,情绪控制粒度较粗,批量生产能力弱。

适合人群: 刚入门试水、偶尔做解说的创作者。

优点: 全球顶级AI语音技术,声音极度拟人化,支持70+语言和声音克隆,情感表达细腻。

缺点: 纯配音工具,不含剪辑功能,需要自己解决音画对齐问题;价格较高,中文支持一般。

适合人群: 有出海需求、追求极致音质、有技术能力处理后期的创作者。

优点: 中文语音效果好,音色选择丰富,支持情绪和语速调节,价格适中。

缺点: 同样是纯配音工具,配音和剪辑分离,需要手动对齐;不理解解说场景逻辑。

适合人群: 需要高质量中文配音、愿意花时间做后期调整的创作者。

优点: 专为电影解说场景设计,配音+剪辑一体化生成,音画天然对齐;自动识别叙事/角色/情绪段落,918种音色+1777种风格;支持10秒采样克隆角色原声;100+语种覆盖,适合出海。

缺点: 功能聚焦解说垂类,不适合其他类型内容;

适合人群: 专注电影解说赛道、追求效率和稳定产出、有批量生产或出海需求的创作者。

如果你还在起号阶段,建议很明确:

别把时间耗在"选完美声音"上。

起号阶段配音的要求是:节奏对、信息清晰、不抢戏。满足这三点就够了。

等跑通稳定播放后,再考虑训练专属音色、尝试真人配音、或用音色克隆建立声音记忆点。

电影解说里,最好的配音不是"听起来很厉害",而是让观众完全没意识到你在"配音"。

这件事,靠情怀解决不了,只能靠流程和工具。

📌 体验入口:

电脑端:https://www.coze.cn/store/project/7597302257427841058?entity_id=1&bid=6iubgvk18700f

移动微信搜索索索小程序"电影解说AI智能体"