当全球还在热议中文模型能否驾驭Rust时,MiniMax直接亮出数据,49.4%的跨语言Bug修复率,硬生生把Claude压到地板上。正是那个拥有100B激活参数、靠单张4090显卡就能运行的开源异类,只要你对多语言编程这个词组稍有耳闻,恐怕都会忍不住发问,它到底凭什么?

更离谱的是,就如同三哥说国产航母下周海试这类事情一样听着挺荒谬的,可人家还真把40种语言放进一个MoE里,而且把船开到了你家门口,难道闭源的壁垒就这么忽然没了吗?不要着急,我来给你分析分析。

开源屠榜:24小时内的神话这事被曝光,是在2025年12月24日,MiniMax在GitHub上发布M2.1权重,在24小时内Star数量超过1.2万。论文挂在arXiv编号2512.13114,页面同步进行更新。

VIBE获得了88.6分,Android子项为89.7,直接把4倍体量的Claude Opus达到了87.9,听起来就好像「拼多多,让iPhone价格降下来」,但数据是明摆着的,就连SWE-Multilingual官方推特都转发了,开源第一次屠榜。

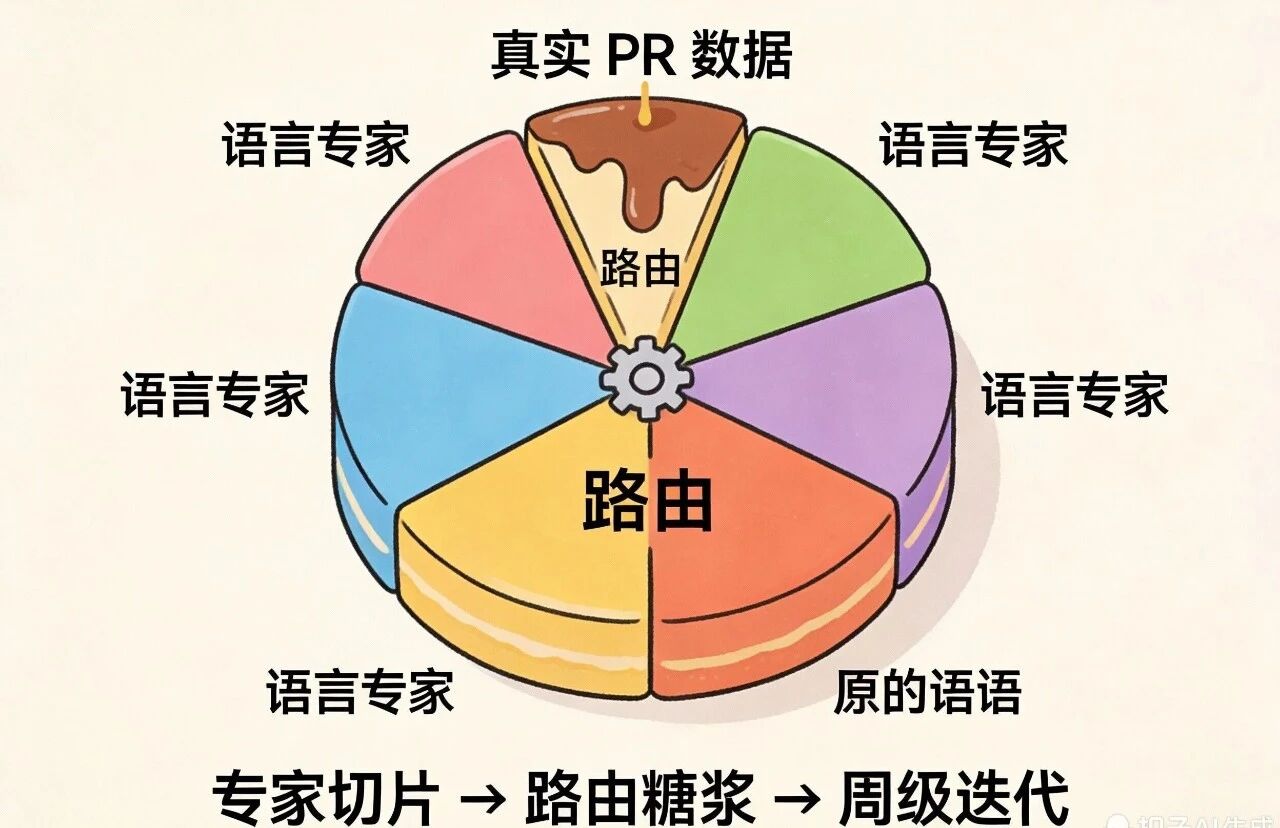

MoE稀疏专家:分语言切片的魔法简单来说,它把专家划分成语言切片,Rust专家仅仅专注于Rust,Go专家专门钻研Go,就好像印度斯坦航空给每一架飞机配备专属的“坠机专员”。

问题来了——专家太多,路由堵车怎么办?MiniMax所运用的是逆向数据飞轮,也就是将线上真实的PR在当日反馈回去,而且每周对RLHF进行迭代,7天内路由决策出错率降低了38%。

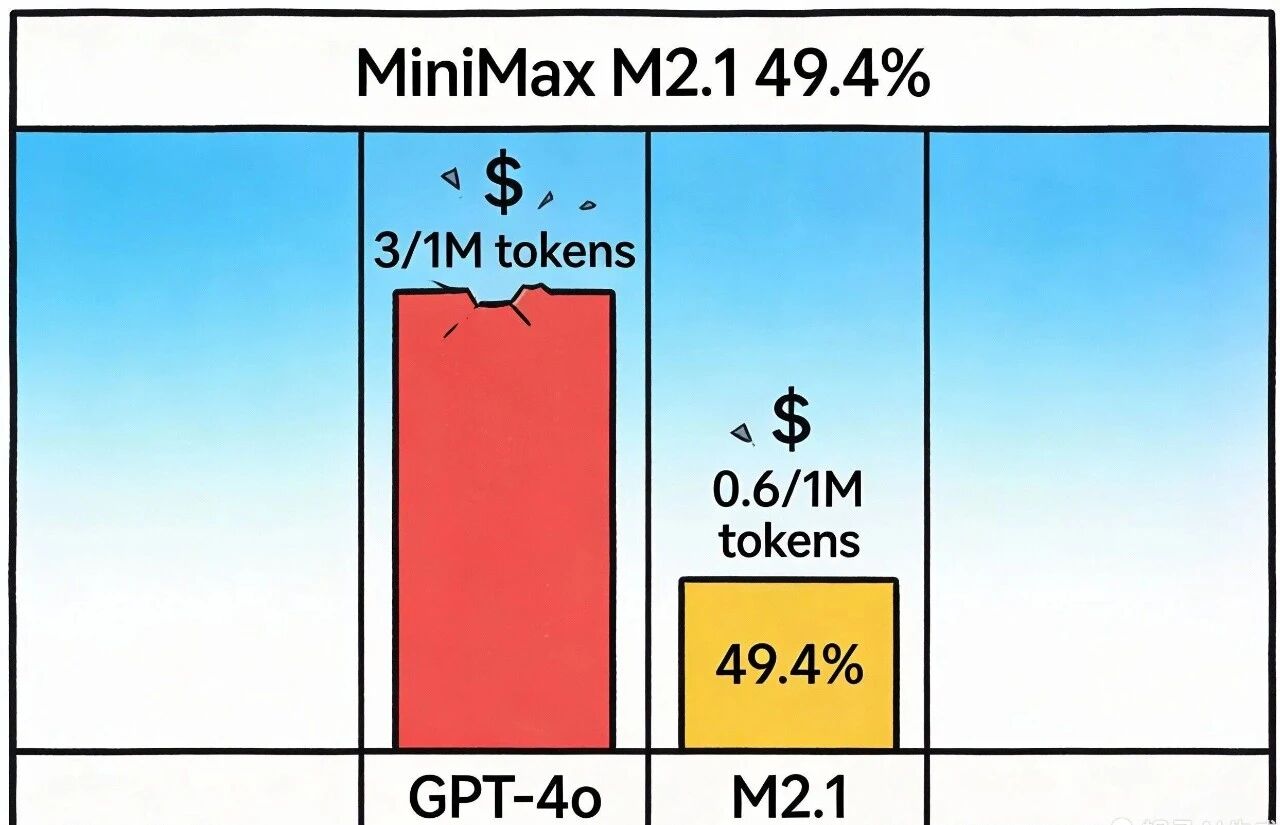

同行还在堆砌稠密参数之时,它却运用稀疏专家来拼乐高,成本直接减少了40%,推理价格就是GPT-4o的六分之一。

成本与性能的双碾压当我们把M2.1和GPT-4o放在一起比较时,差距一目了然。

成本方面

:M2.1的推理成本仅为GPT-4o的1/6(0.6美元/百万token vs 3美元/百万token)性能方面

:M2.1在跨语言Bug修复任务中达到了49.4%的成功率,这一成绩足以让许多闭源模型汗颜对于企业和个人开发者来说,这意味着他们可以用更低的成本获得更高的开发效率。凌晨3点还在和Bug较劲的程序员,终于可以松一口气了。

开源模型翻车的情况还少吗?2023年Meta的CodeLlama宣传得那叫一个厉害,结果一测试多语言,除了Python之外全都不行,Rust的修复率才9%,被人调侃说“除了Py,全是垃圾。”

聪明归聪明,但是M2.1真不会重蹈覆辙?历史向我们显示,要是训练语料里缺了一行真实报错日志,模型就会给你整出“HelloWorld核弹发射器。”

Multi-SWE-Bench分数虽高,但涵盖的2800道题目中,70%依然是英文注释,中文、日语、阿拉伯语的信息加起来还不到5%,实际应用时会不会一碰上非英语场景,模型就束手无策?

非英语贡献者的春天在开源社区,非英语贡献者一直处于相对弱势的地位。语言壁垒使得他们的代码和贡献难以被全球社区理解和接受。

M2.1的出现改变了这一局面。它支持中文、阿拉伯语、日语等多种语言的代码理解和生成,使得非英语开发者的贡献也能被"看见"和"理解"。

闭源高墙出现裂缝但你要说“闭源护城河依旧”,也不见得。技术层面,MoE稀疏路由将1000亿参数压缩成200亿激活状态,单机8个A100便能够支撑1万次并发,成本曲线相较于稠密模型陡降。商业层面,开源许可证(Apache2.0)让云厂商敢于将价格压至0.6美元每百万token,而Claude3.5还收取3美元。生态层面,Cursor已经内置M2.1插件,24小时下载量达到18万次,形成「模型-IDE-开发者」的循环。

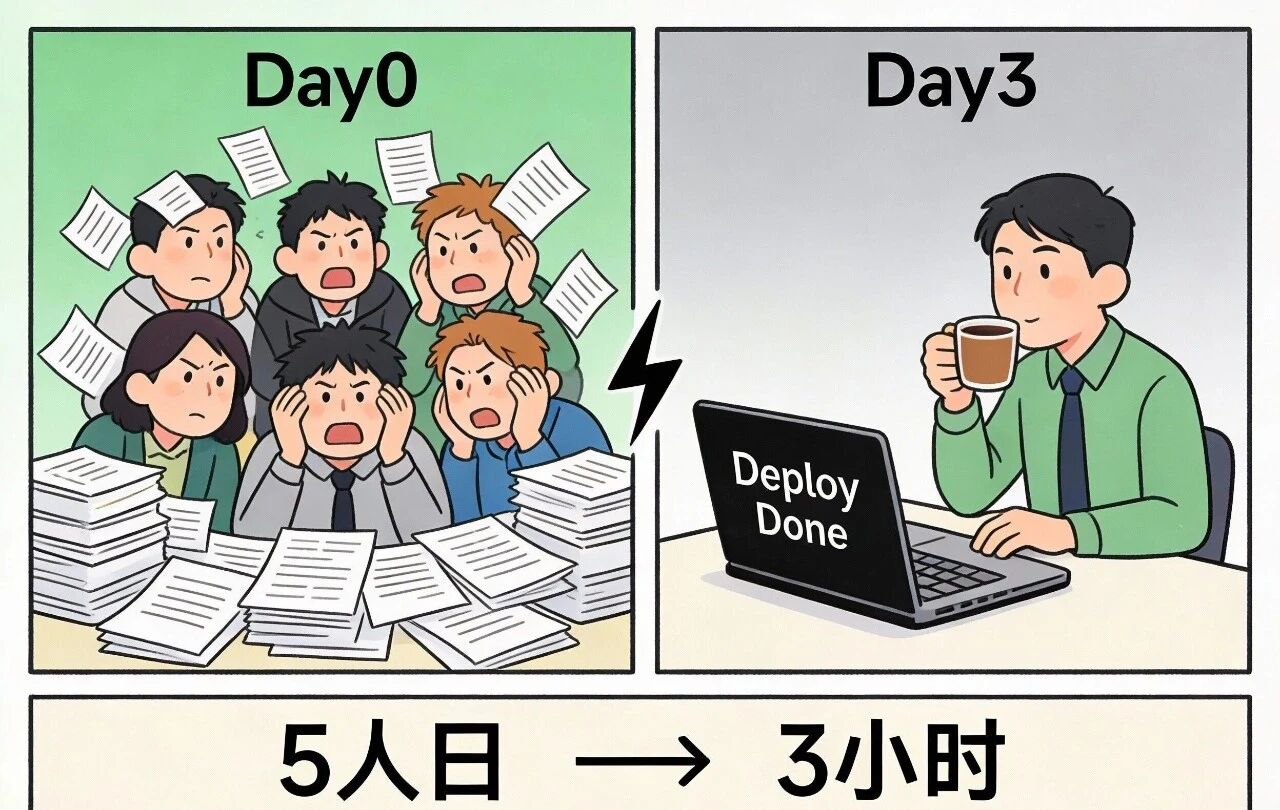

三箭齐发,闭源高墙出现裂缝。某跨境电商在72小时内借助M2.1完成Kotlin后端与React前端的全面重构,原本需5人日的工作压缩至3小时搞定,CPU使用率还下降了12%。

相比之下,2024年某大厂采用闭源模型进行Java系统重构,投入预算高达200万,却因频繁出现逻辑偏差,接连回滚三次,最后不得不削减功能需求收场。

关键差别不在于聪慧,而是在于可操控。开源能够让工程师本身去添加微调数据,要是闭源的话就只能等着官方发布版本,节奏相差了整整一个季度。

2026:全语言彩虹桥的未来这并非参数军备竞赛的终点,而是一场围绕成本、可控性与生态的三维淘汰赛,谁能将开源的低成本转化为闭源级别的优质体验,谁才真正掌握主动权。

还有一句更尖锐的:发布会再惊艳,现实依旧残酷,公关话术里从不存在一键奇迹,有的只是凌晨三点还在调试路由的工程师。

现实情况是,M2.1已将多语言编程的门槛从「百万美元级别的密集集群」直接拉低至「一张4090显卡就能搞定」。这给闭源模式敲响了警钟,倘若还指望靠着又大又贵的方案躺着赚钱,用户迟早会用行动做出选择。

展望2026年,当稀疏专家模型被压缩到仅需10B激活参数、手机终端也能流畅运行时,编程语言之间的所谓鄙视链可能就只剩一句话:能跑起来就别扯废话。

结语MiniMax M2.1的发布,不仅是AI技术的一次重要突破,更是开源社区的一次胜利。它证明了开源模型不仅可以在性能上与闭源模型抗衡,还能在成本上实现碾压。

对于开发者来说,这意味着我们有了更多的选择,不再被闭源模型的高墙束缚。我们可以用更低的成本获得更高的开发效率,将更多的时间和精力投入到创新和创造中。

当然,我们也不能忽视M2.1存在的问题和挑战。幻觉、安全等问题仍然需要我们认真对待和解决。

但无论如何,MiniMax M2.1已经为我们打开了一扇新的大门。未来的AI世界,将是开源与闭源并存的世界,而开发者将成为最终的受益者。

让我们一起期待,M2.1和更多开源模型带来的下一个惊喜。

声明:本文内容95%左右为人工手写原创,少部分借助AI辅助,但是所有的内容都是本人经过严格审核和核对的。

评论列表