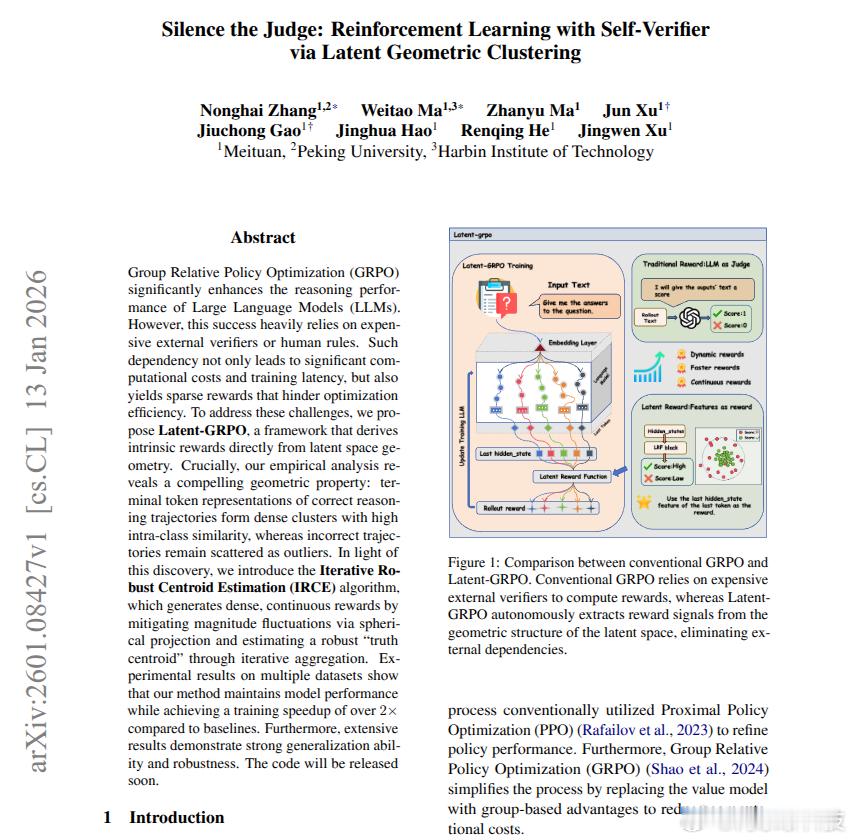

本文通过将隐藏状态聚类转化为驱动强化学习的奖励,利用强化学习训练 LLM,但无需外部评判。它消除了判断瓶颈,因此推理训练变得更快、更便宜、更稳定。外部评委或手写规则使得分组相对策略优化 (GRPO)(即对一组答案进行训练)速度缓慢,而据报道,如果没有这些规则,训练速度可提高 2 倍以上。更糟糕的是,大多数奖励只有 0 或 1,因此该模型几乎无法获得有关险些成功的线索。作者发现,正确的解决方案最终都具有相似的隐藏状态,这些内部信号概括了整个推理过程。Latent-GRPO 取每个采样答案的最后一个标记隐藏状态,运行迭代鲁棒质心估计 (IRCE),这是一个重复的平均步骤,可以降低异常值的权重,然后根据与中心的接近程度给出平滑的奖励。他们使用 3 个推理数据集进行测试,分别是小学数学应用题 (GSM8K)、竞赛数学 (MATH) 和混合推理指令 (Open-Platypus),分别在 0.6B、1.7B 和 4B Qwen3 模型上进行测试,并与 LLM 作为评判者(外部评分者)进行比较。它在保持准确性的同时,训练速度更快,使得用于推理的强化学习成本更低、稳定性更高。论文链接 – arxiv.org/abs/2601.08427论文题目:“让法官闭嘴:基于潜在几何聚类的自验证强化学习”科技先锋官ai生活指南ai创造营