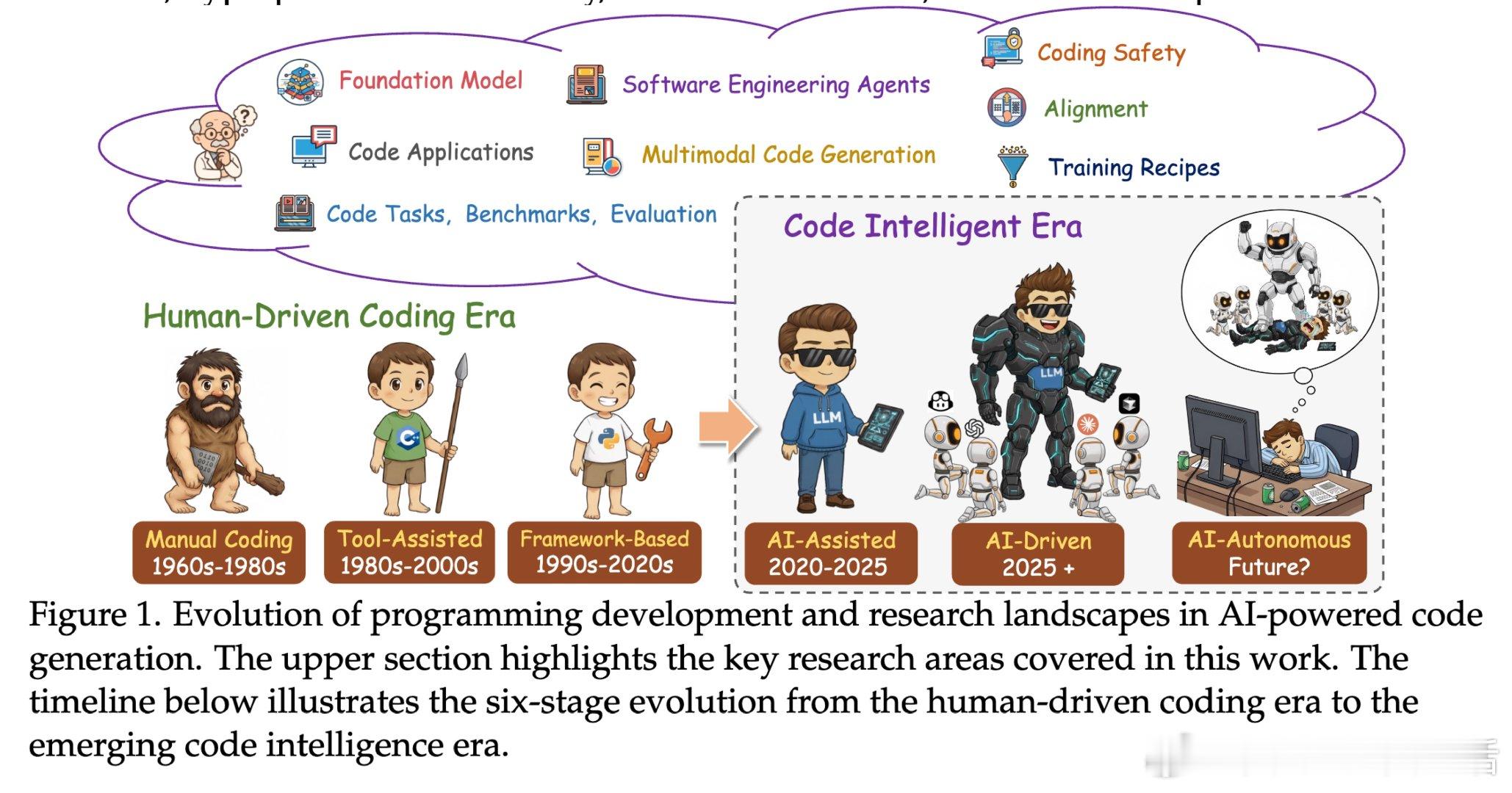

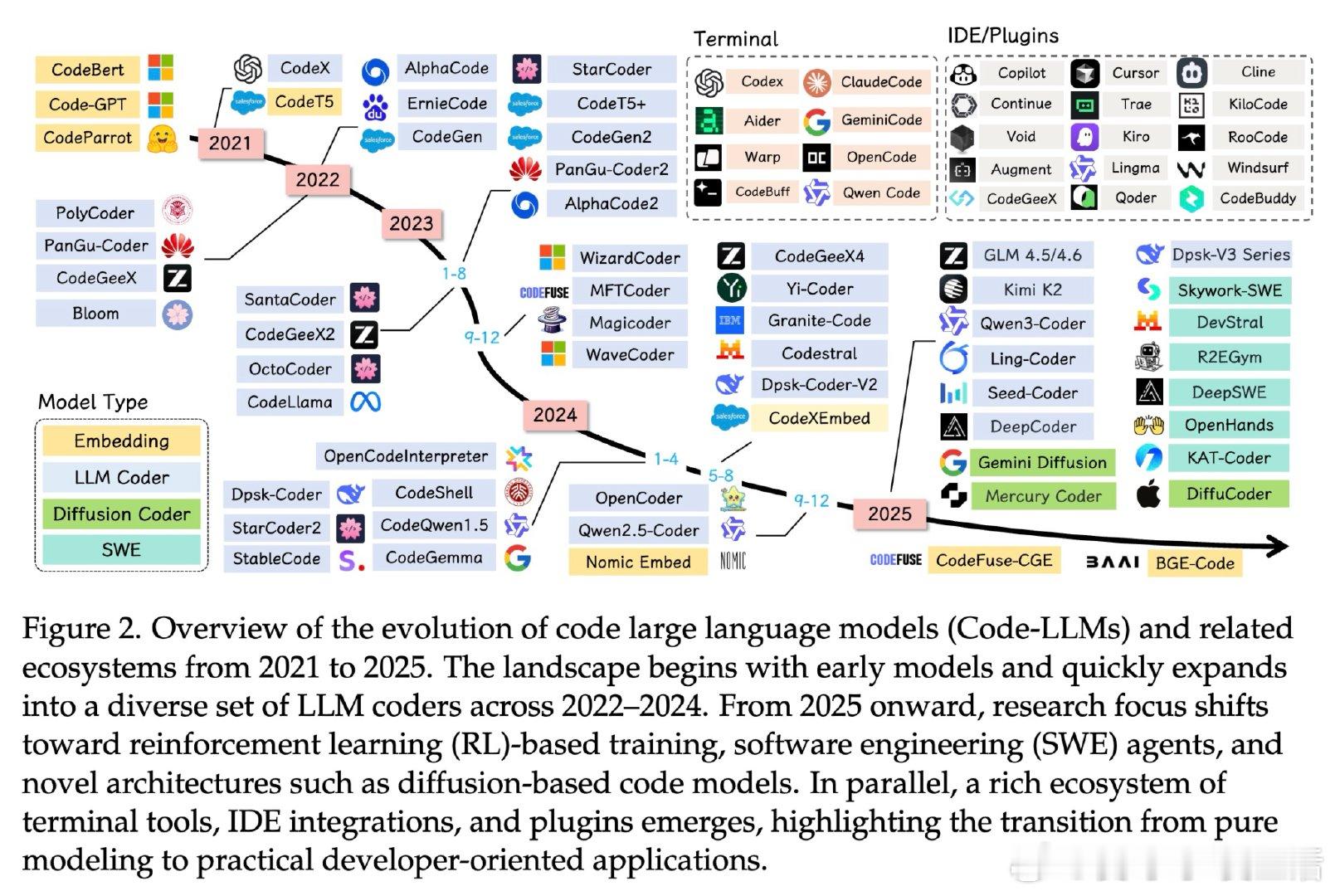

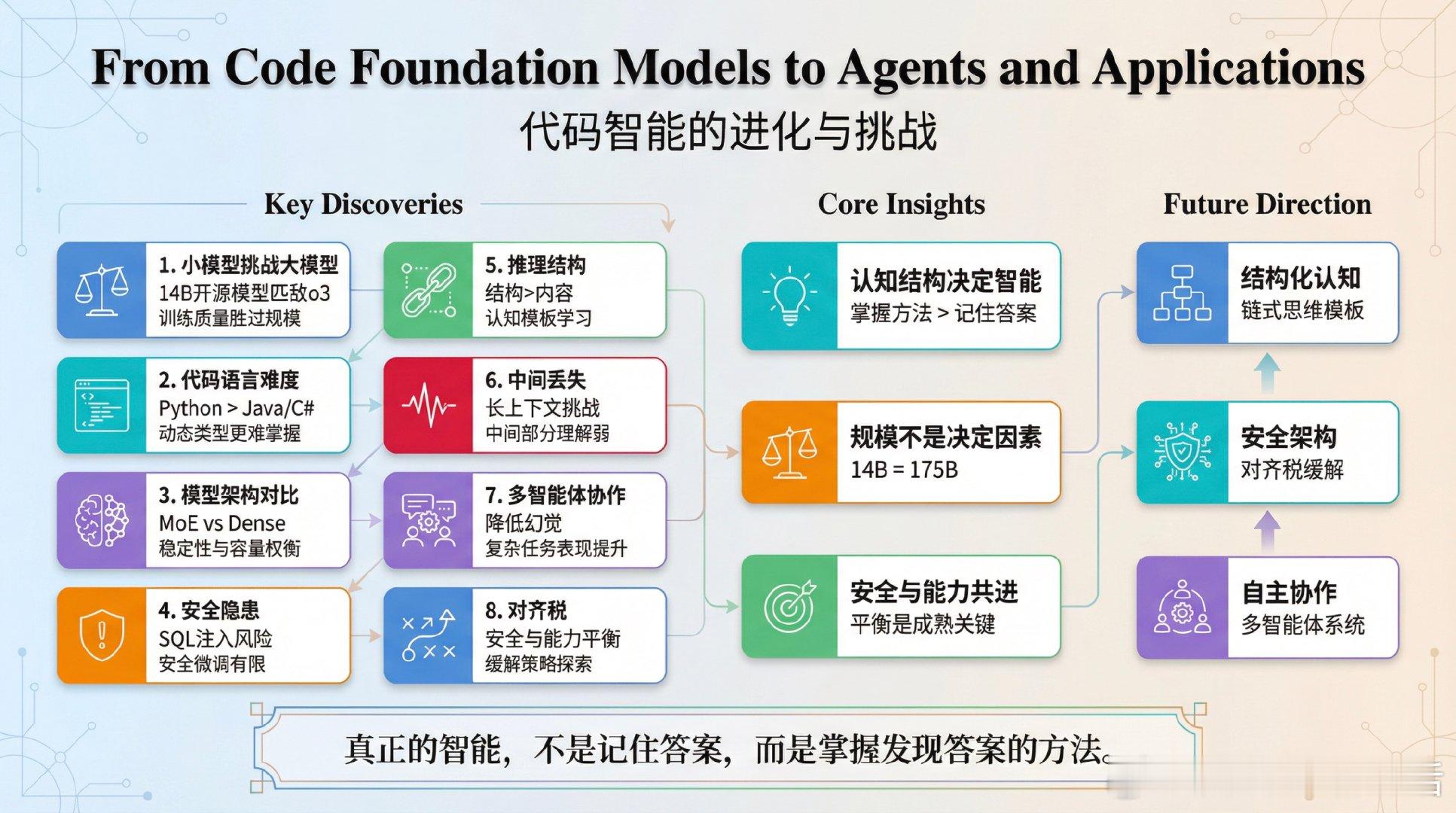

《From Code Foundation Models to Agents and Applications: A Practical Guide to Code Intelligence》本文揭示了代码生成模型和智能体训练中的多项关键发现,对AI发展有深远启示:1. 小型开源大模型(LLM)有望超越巨头。通过RLVR(可验证奖励强化学习)训练的14亿参数模型,在推理能力上能匹敌OpenAI的o3,证明模型规模不是唯一决定因素,训练质量和反馈机制更关键。2. 代码语言难度不一。Python因动态类型特性,反而比静态类型语言(如Java、C)更难学。类似语法语言混合训练带来协同效应,但Python与静态语言混合过多反而影响模型表现。3. MoE(专家混合)模型容量大但训练脆弱,超参数敏感;而Dense模型更稳定,训练更易把控。MoE需特殊学习率调度以防路由不稳定。4. 训练代码模型存在安全隐患。公开代码库中大量不安全编码模式被模型学习,安全微调效果有限。模型能拒绝写仇恨言论,却可能生成含有SQL注入漏洞的代码。5. 推理训练中“结构”远胜“内容”重要。模型通过学习链式思维(CoT)的“认知模板”,掌握问题拆解方法,而不是死记硬背事实。设计合成训练数据时,步骤结构比每条中间事实的准确性更关键。6. “中间丢失”问题依然存在。虽然支持超大上下文,模型对提示中间部分代码的理解仍不稳定,准确率下降。7. 多智能体辩论显著降低幻觉,提升复杂软件工程任务表现。但辩论设计需谨慎,否则可能引发幻觉强化。8. 安全对齐(alignment)往往牺牲代码能力,论文提出缓解“对齐税”的策略,期望安全与能力共进。这份研究颠覆了“规模即王道”的传统认知,真正的智能来自对认知结构和训练质量的深刻理解。AI的未来不在于参数多少,而在于训练方式、反馈机制和安全架构的精细设计。正如文中所说:“真正的智能,不是记住答案,而是掌握发现答案的方法。”链接:arxiv.org/pdf/2511.18538这不仅是一篇技术论文,更是AI进化的路线图。未来,AI模型将更注重结构化认知、稳定性、安全性与协作能力,推动智能系统迈向更高阶的自主推理与安全实践。对于AI工程师和研究者来说,这是一份必读的宝藏。思考:规模的迷思正在被理性取代,AI的价值在于“如何思考”,而非“记住多少”。安全与能力的平衡,是AI走向成熟的关键门槛。