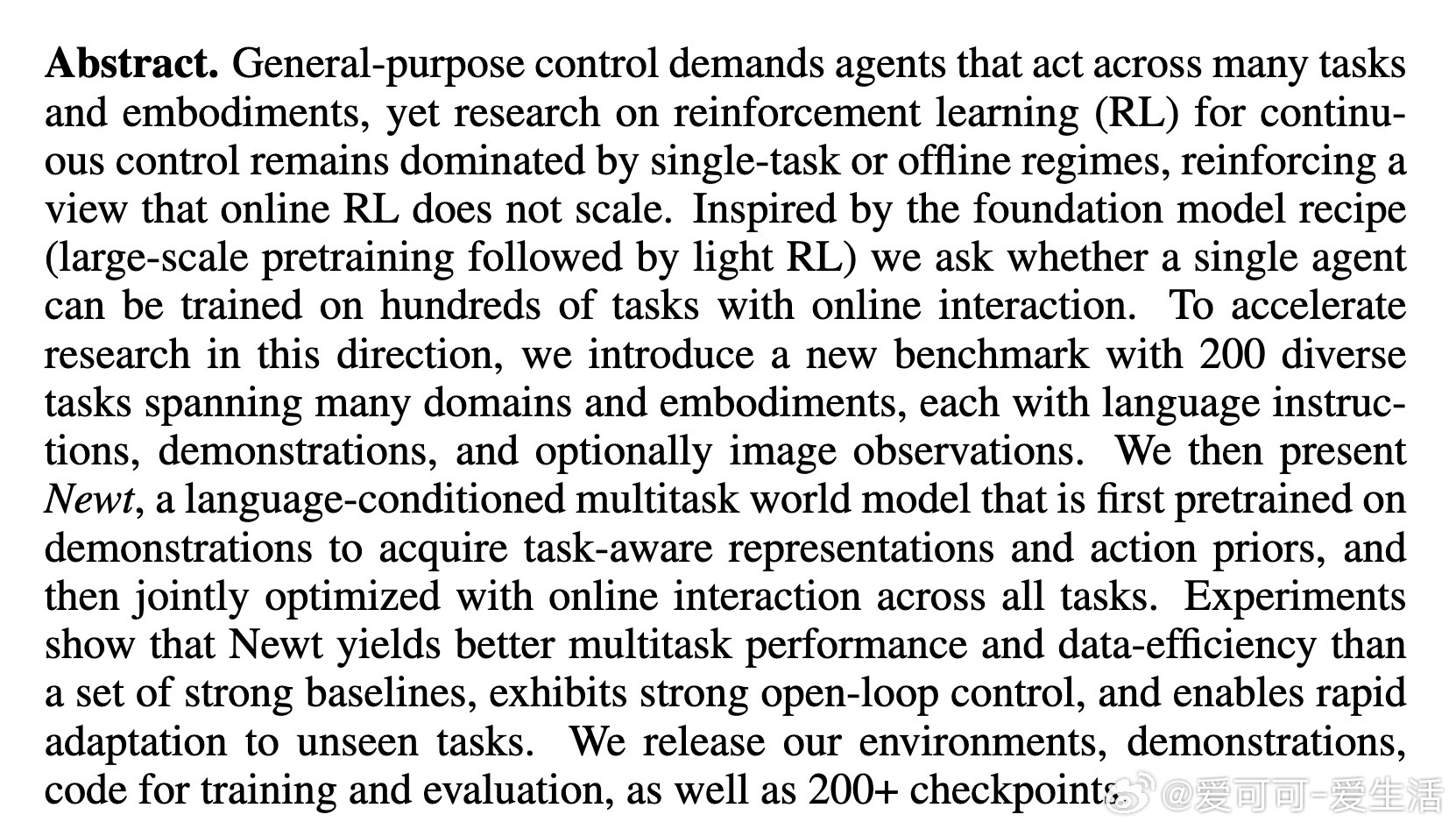

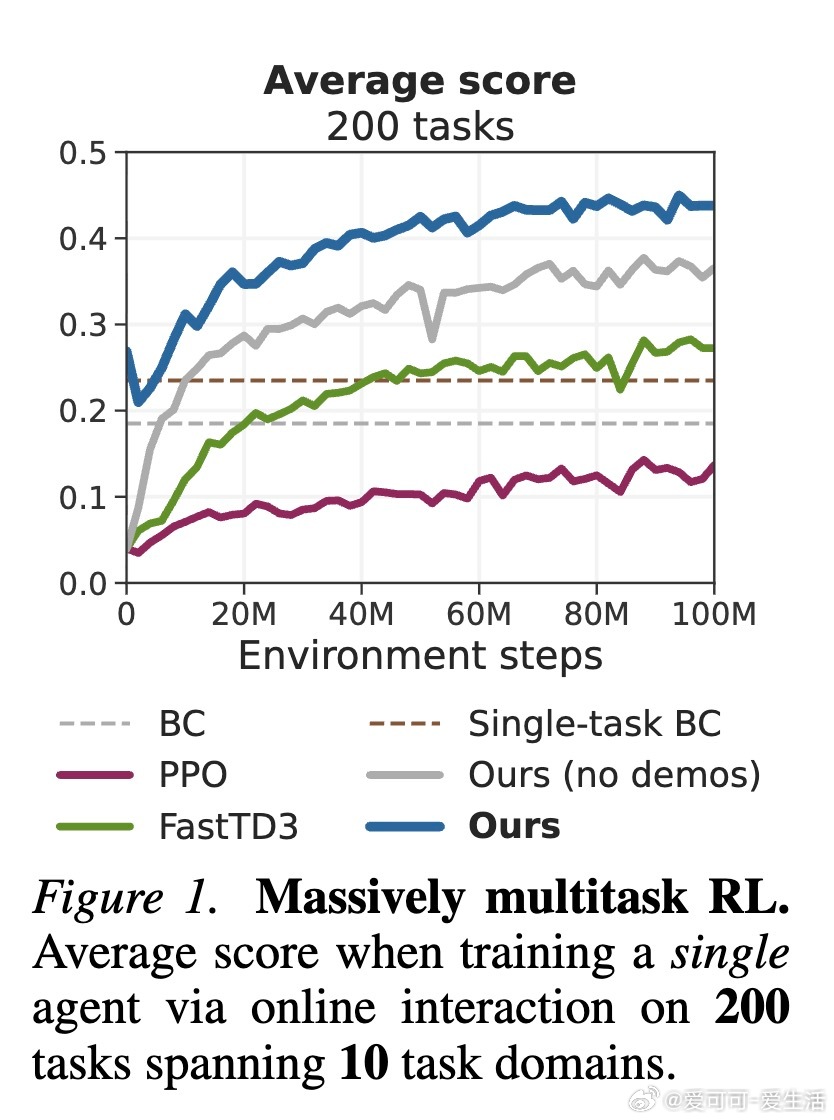

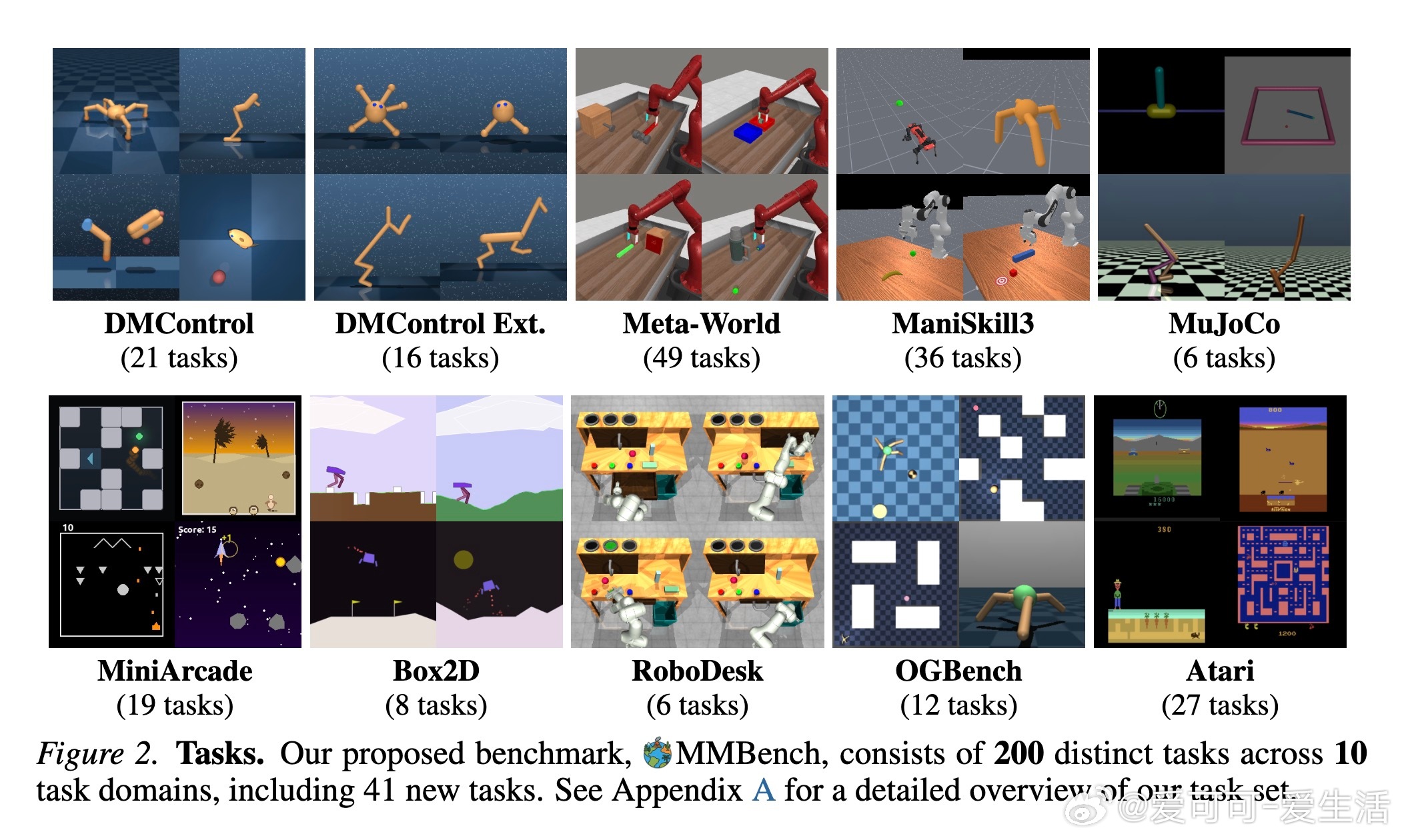

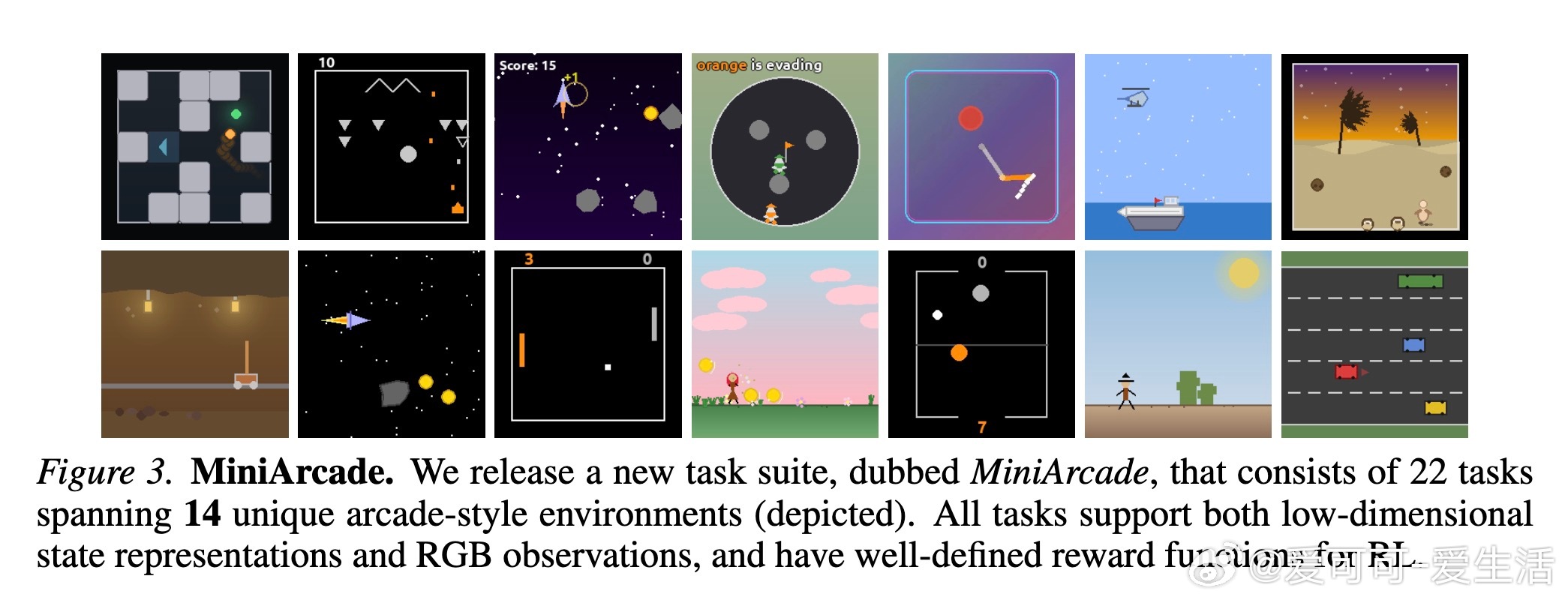

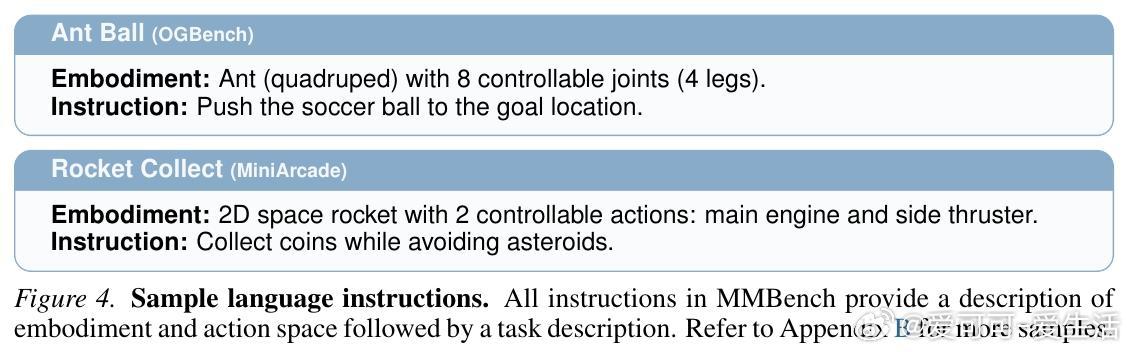

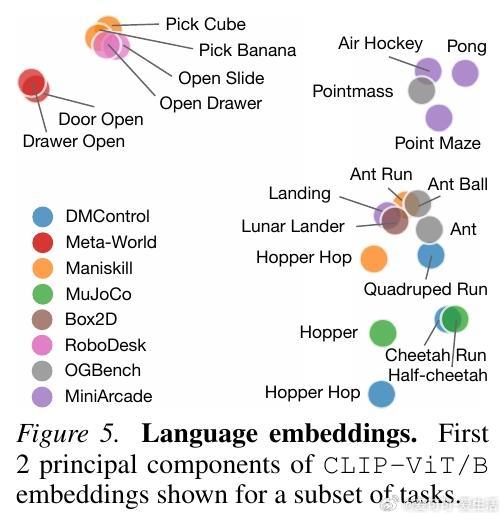

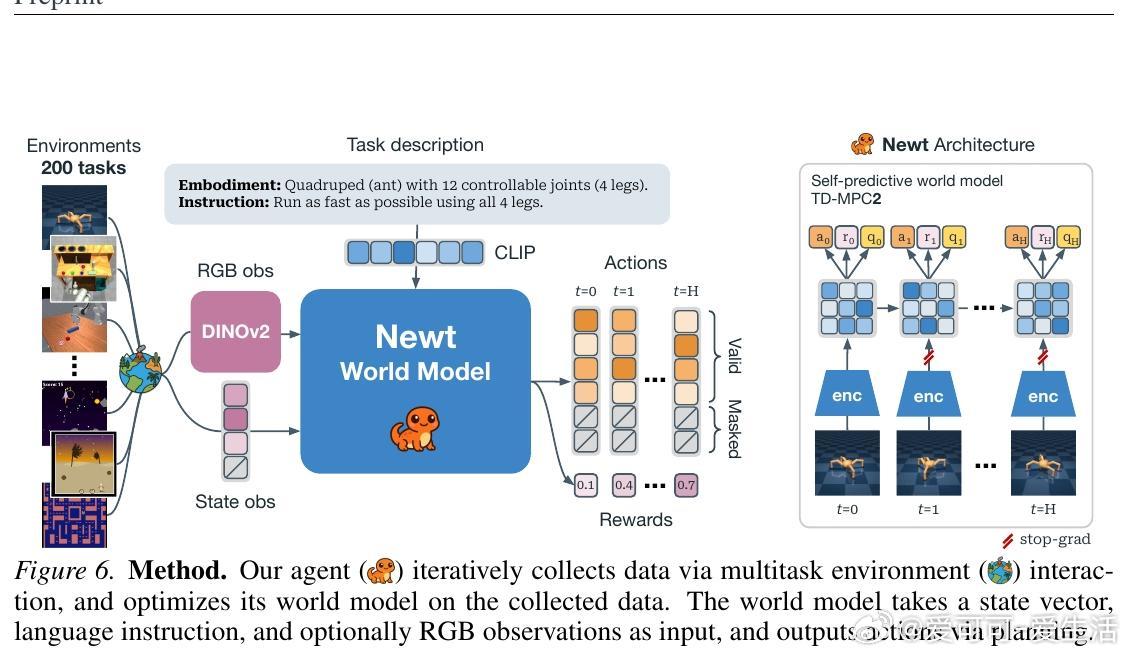

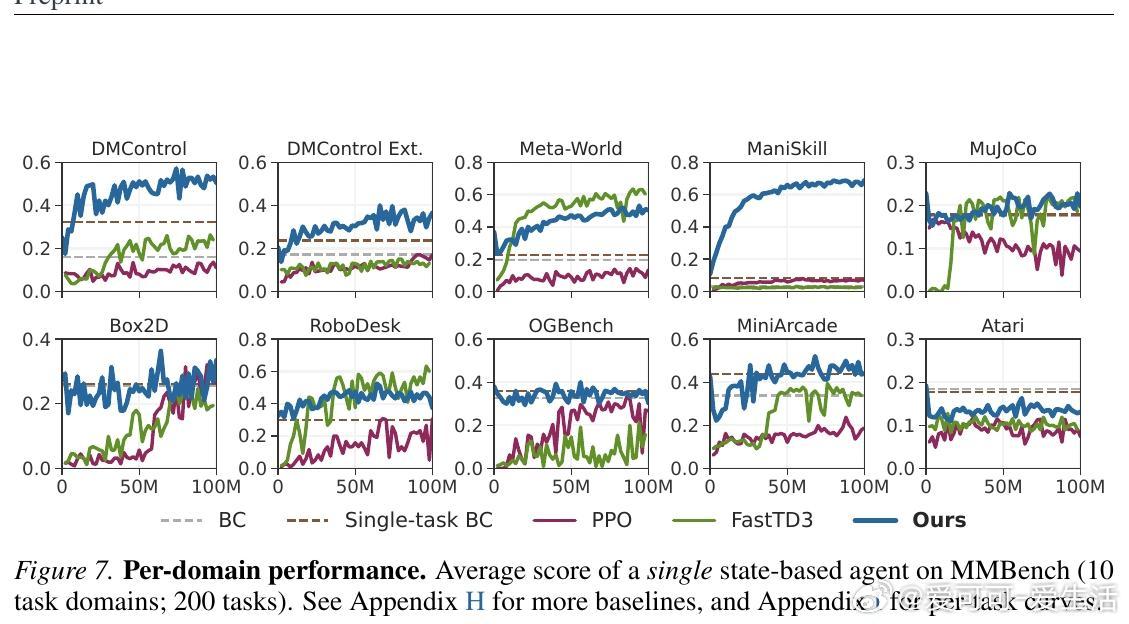

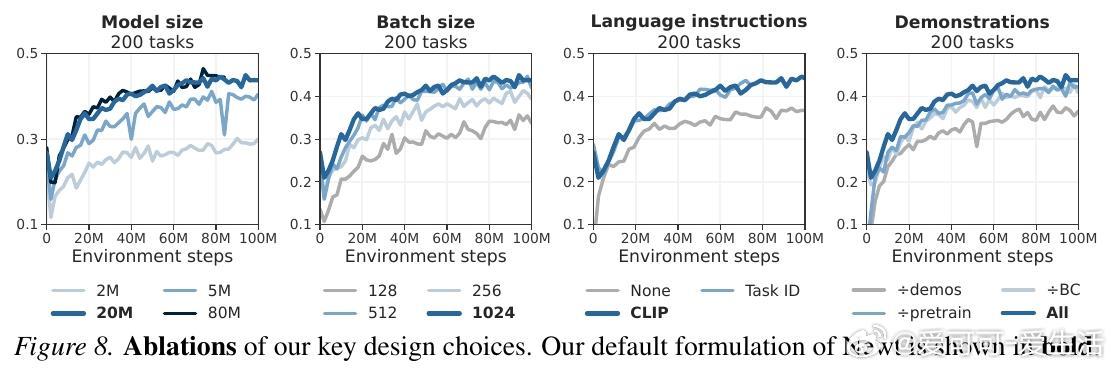

[LG]《Learning Massively Multitask World Models for Continuous Control》N Hansen, H Su, X Wang [University of California San Diego] (2025) 如何让一个智能体在线同时学习数百个连续控制任务?本文提出了开创性的工作:MMBench基准和Newt多任务世界模型。MMBench包含200个多样化任务,涵盖10大领域,从机器人操作、运动控制到街机游戏,每个任务配备语言指令、示范数据和可选图像观测,支持多模态研究与训练。Newt基于TD-MPC2模型预测控制框架,创新性地融合语言和视觉编码,先利用示范数据预训练获得任务感知表示和动作先验,再通过在线交互联合优化,显著提升多任务性能和数据效率。关键成果包括:1. 单一智能体能在线高效学习200个任务,表现优于PPO、FastTD3等强基线。2. 充分利用示范数据缓解探索难题,结合模型预训练、示范过采样及行为克隆监督,保障训练稳定。3. 支持长时序开环控制,实现无反馈下的连续动作规划,表明世界模型对环境动态有深刻理解。4. 具备快速适应未见任务和不同体型的能力,展现良好泛化潜力。5. 语言条件输入显著帮助区分任务,促进多任务学习及跨任务迁移。6. 视觉输入对操作类任务有明显增强效果,但对某些控制任务提升有限。此外,团队开放了超过200个模型检查点、4000+示范数据、训练与评估代码,以及完整的MMBench任务集,极大促进社区研究与复现。未来挑战与机遇:- 视觉强化学习的计算成本与稳定性仍需突破,结合大规模预训练与创新数据管线是关键方向。- 语言理解能力瓶颈限制泛化,需探索更细粒度语言学习与数据增强。- 设计更强大模型架构(如Transformer、扩散策略)以提升表现。- 深入解析模型潜在空间结构,挖掘多任务世界模型潜能。- 动态训练策略和任务采样优化以提升学习效率。- 扩展环境和数据集规模,推动通用控制智能体发展。这项工作首次展示了在线强化学习可扩展至大规模多任务连续控制领域,为构建通用型智能体奠定了坚实基础。开放资源期待更多研究者加入探索,推动多任务强化学习跨越新高度。详细阅读与下载:arxiv.org/abs/2511.19584项目主页:www.nicklashansen.com/NewtWM