在摩尔线程的首届MUSA开发者大会上,除了公布新一代GPU的产品线路图外,还发布了AI算力本MTT AIBOOK,它虽拥有笔记本形态,但内核与目标,指向一个更专业的领域:一款好用的AI工具,专为AI学习与开发者打造的Linux开发本。

MTT AIBOOK是一款基于摩尔线程自研SoC“长江”所打造的AI终端产品,可提供50 TOPS的异构AI算力,支持INT8/FP16/FP32等混合精度计算,可流畅运行各类主流大模型与AI应用。它首次将全栈自研技术、全功能GPU、原生AI环境与开发工具链深度整合,大幅降低AI开发门槛,提供“开箱即用”的一站式体验。

我们测试这台MTT AIBOOK所用的时间比其他产品长得多,因为这是一个全新品类,不能只用常规手段测测数据跑跑分,而是从开发者角度去测试其作为AI开发生产力的各项性能。现在,我们就一同来体验这款与众不同的MTT AIBOOK。

开发环境:AI工具链,开箱即用做过AI开发的人都知道,配置环境往往比写代码更折磨人。CUDA版本冲突、依赖库报错、驱动不兼容……这些能耗掉新手数天的时间。

MTT AIBOOK最大的价值不在于硬件堆料,而在于它是一套“开箱即用的AI开发环境”,直击痛点。

AI原生系统:MT AIOS

MTT AIBOOK运行的是基于Linux内核与自研MUSA架构打造的MT AIOS操作系统。它从底层实现了对AI任务的高效调度,充分发挥CPU、GPU、NPU的异构协同性能。

更重要的是,系统预装了一整套主流AI开发工具链:包括内置Python、VS Code、Jupyter等,而且还预装了PyTorch、vLLM、Pandas、Matplotlib、Numpy和Ollama等常用库,支持Docker。这意味着开发者开机即可直接import torch,无需把时间浪费在环境配置上,真正实现了“开箱即用”。

MTT AIBOOK是一款14英寸的算力本,尺寸为312.2*221.5*15.7mm,重1.5kg,相当之轻便。它采用摩尔线程研发的“长江”SoC,最高主频2.55GHz。配备32GB LPDDR5X 7500MT/s高速统一内存与1TB SSD,搭载2.8K OLED屏幕、4阵列麦克风和4超线性扬声器,在视听方面能带给用户优秀的体验。

秉承“一本多用”的开放理念,通过深度优化的虚拟化与容器技术,将Linux、Windows、Android三大操作系统生态整合于单一设备,并适配国产操作系统。

光有环境不行,还得看实战。我们将通过推理、创造、开发、训练四个维度,测试这台机器作为“移动AI工作站”的真实战力。

推理:本地部署vLLM与RAG知识库

在推理环节,我们并没有把时间浪费在繁琐的环境搭建上——因为AIBOOK已经预装了vLLM-MUSA推理框架。对于开发者来说,这种“Ready-to-Code”的状态极具吸引力。我们只需要在HuggingFace镜像站或者魔塔社区把模型拉到本地,然后在终端上输入指令,即可一键启动vLLM的服务。

由于AIBOOK预装了VS Code,所以在上面写python代码其实更为轻松。我们实测用Python代码调用本地模型介绍“北京名胜古迹”,模型加载迅速,tokens生成速度很流畅。这证明了摩尔线程的软件栈在推理侧已经能够很好地释放底层算力。

用python代码让大模型介绍了一下北京的名胜古迹

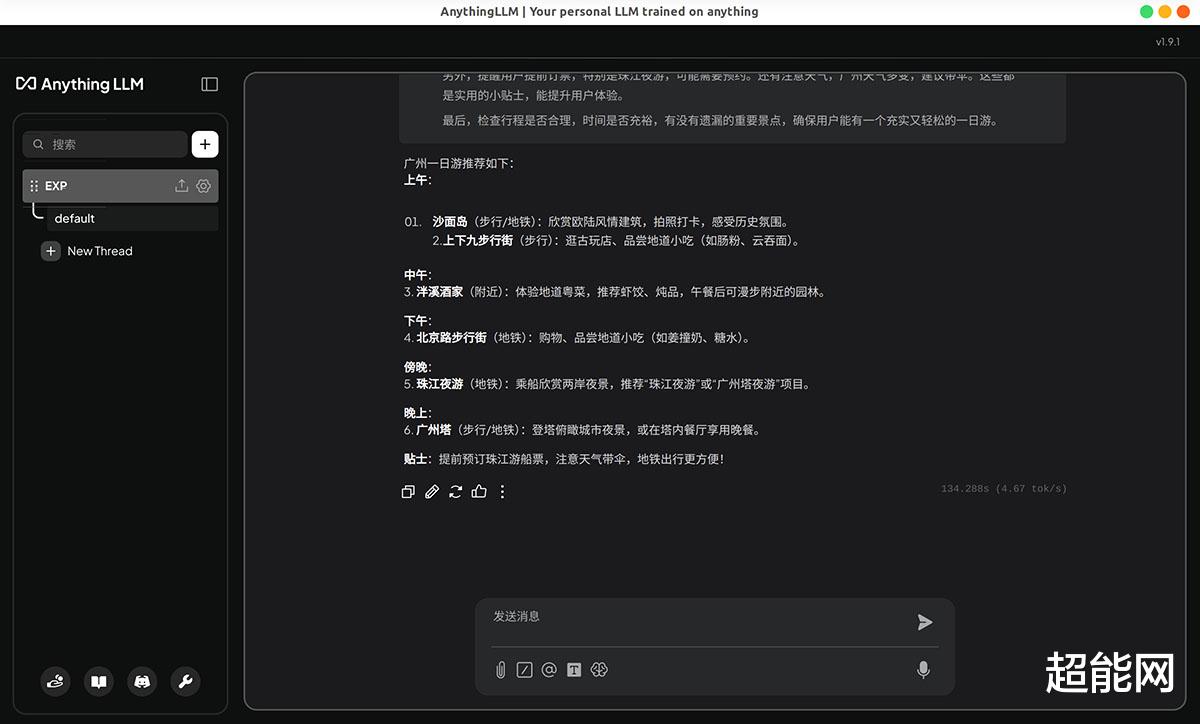

当然了,单纯依赖命令行进行交互虽然“硬核”,但在长轮次对话场景下不够直观,可以美化一套UI,这个选择就有很多了,我们就装了Anything LLM,可以通过它和vLLM启动的模型进行对话。

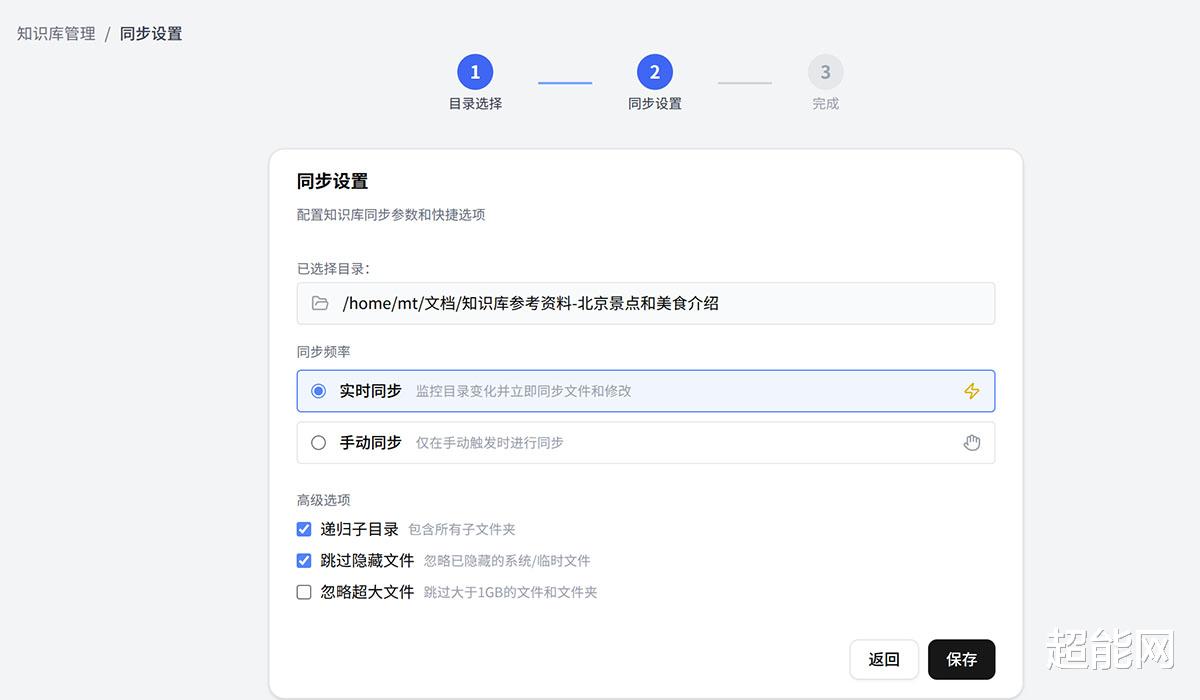

AIBOOK内置的RAGBASE本地个人知识库是另一个惊喜。它利用RAG(检索增强生成)技术,解决了大模型“胡说八道”和“不懂私有数据”两大痛点。

默认的模型都是内置的,可以分开设置对话用的模型和数据向量化所用的模型,内置的模型其实就是Qwen3-8B,也可手动添加模型,支持在线的模型API或者本地的Ollama服务。

上传文件给本地知识库,可以指定目录让程序自动导入

我们尝试将一份几十页的文档“喂”给系统。实测中,本地运行的Qwen3-8B 模型表现出了极高的可用性:它不仅能精准定位文档中的核心数据,还能基于内容生成逻辑严密的摘要。

相较于云端方案,这种纯本土化的好处在于,不仅大幅提升了准确率并减少“AI幻觉”的概率。并且,从向量化处理到模型生成,所有数据流转均在本地闭环,这意味着,无论是财务报表还是未公开的技术方案,你都可以放心地交给它处理,彻底杜绝了数据上云的泄露风险。

创造:ComfyUI文生图实战ComfyUI是内容创作者经常会使用的工作流,也是目前最具代表性的节点式AI工作流工具,同时也是检验显卡生态兼容的“试金石”。

这一点上,MTT AIBOOK 给了我们不小的惊喜。尽管 ComfyUI原生基于CUDA开发,但摩尔线程通过对底层 PyTorch及加速接口的深度重构,成功打破了生态壁垒。

在AIBOOK上,ComfyUI是没预装的,需要自己拉并下载所需的python库,启动后还需要下载模型,这一个步骤其实不难。整个环境部署过程非常顺畅,并未出现国产卡常见的“依赖冲突”或“算子缺失”报错,这侧面印证了MUSA软件栈的成熟度。

我们就使用了经典sdxl模型生成了一些1024*1024分辨率的照片,MTT AIBOOK生图所花的时间还是很短的,出图效率远超我们对一台轻薄本的预期,它能够很好胜任移动端的AIGC创作需求。

如果有兴趣的朋友入手后可以自行搭建使用更新的LoRA模型看看能生成怎么样的精美图片。

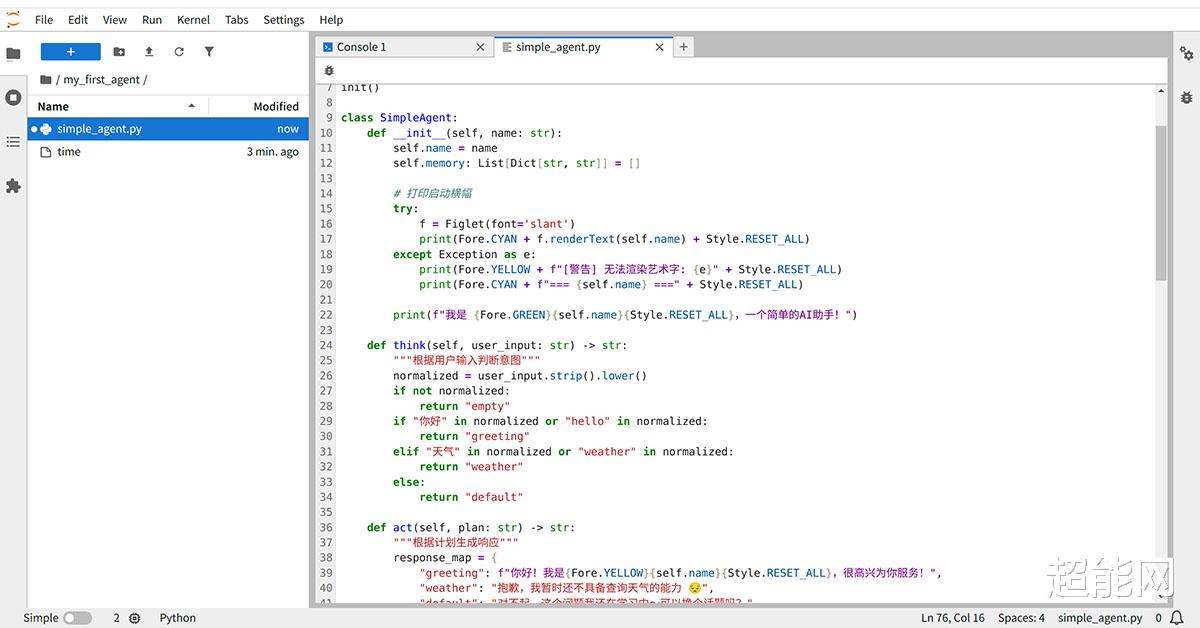

开发:从零搭建Agent智能体仅仅只会跑现成的模型还不够,AIBOOK的核心定位是“开发工具”。为了验证其编码实战体验,我们利用系统内置的Jupyter Notebook,尝试从零构建一个AI Agent 原型。

这个智能体是根据摩尔线程提供的教程搭建的,后续AIBOOK相关教程也会在摩尔学院。AIBOOK内置了Jupyter Notebook,可以很方便的利用它来编写python代码。

整个开发过程比较顺畅。得益于预装的完整Python环境及主流AI库,我们完全跳过了最耗时的依赖配置环节,可以直接进入代码逻辑的编写。

最终搭建好后的AI智能体可以在终端上运行,并且根据我提出的问题作出回答,是一个包含“思考 - 行动 - 记忆”核心要素的智能助手原型以及框架。基于这套框架,开发者可以快速扩展出丰富多样的应用,例如养成类的电子宠物、或是基于个人数据的健康管理助手。

这也是AIBOOK的价值所在,抹平了底层的技术门槛,让开发者只需专注于创意与逻辑本身。无论是新手入门还是快速原型验证,这种“开箱即写”的体验都极大地提升了开发效率。

训练:云端算力无缝调用任何移动工作站的本地算力终究是有限的,但AIBOOK作为摩尔线程MUSA 统一生态的一环,可以快速接入摩尔线程云端算力。这样一来,开发者可以在本地AIBOOK上完成代码编写与调试,遇到重负载训练任务时,无缝调用云端的摩尔线程算力集群。

为了验证这种“端云协同”的流畅度,我们在AutoDL平台上接入了一台使用摩尔线程MTT S4000 GPU的服务器,并利用AIBOOK已经预装的JupyterLab直接连接云端,进行CIFAR-10图像分类训练测试。

使用CPU进行训练的话平均每epoch耗时是9秒

而使用GPU训练的话平均每epoch耗时则是6秒,速度明显更快

实测显示,在云端算力加持下,训练速度相比纯CPU方案提升明显。在使用基础CNN模型时,GPU加速将每epoch耗时缩短至6秒左右。即便是切换到计算量更大的ResNet模型,云端算力也能保持高效稳定的迭代速度,迅速将模型准确率推升至90%以上。

当然,本次CIFAR-10训练测试只是一种能力展示,但AIBOOK这种“本地轻量开发+云端重载训练”的模式,很好平衡了便携性与高性能需求。

训练完后的测试结果

最关键的是,训练并非终点。由于端云均采用统一的MUSA架构,我们在云端训练好的模型权重,可以直接拉回AIBOOK本地进行加载和推理,不存在任何兼容性隔阂。这也许就是开发者真正需要的“无缝”体验。

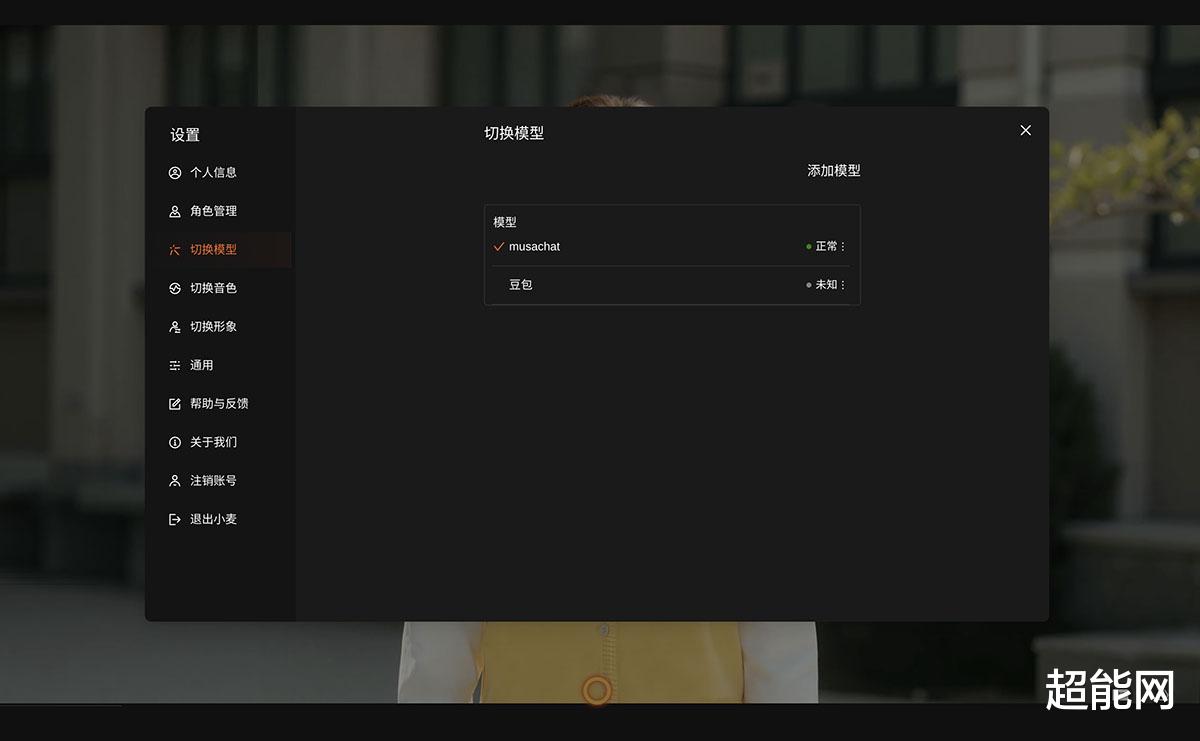

AI应用体验:零代码,造一个数字人AI数字人小麦除了硬核的代码开发,MTT AIBOOK在多模态应用上也展现出了极强的可玩性与实用性,其中最具代表性的就是——数字人“小麦”。

“小麦”并非简单的语音助手,它是语音识别(ASR)、大语言模型(LLM)、语音合成(TTS)与实时渲染技术的完整融合。得益于全功能GPU的算力支撑,小麦的形象渲染完全在本地端侧完成,支持2K高清分辨率与流畅交互。

在数字人“大脑”的选择上,系统提供了极高的自由度:默认调用摩尔线程自家的云端大模型MUSAChat-72B,具备出色的理解与推理能力,可准确完成知识问答、逻辑分析等复杂任务,也可以自行添加其他模型API,比如豆包或千问什么的,以满足各类专业场景需求,让智能交互更高效可靠。而对于网络延迟敏感的场景,用户可一键切换至本地语音识别引擎,获得更极致的响应速度。

同时运用“小麦”能力,你也可以快速造一个自己数字人/想要的数字人。在“角色管理”中,我们无需编写任何代码,就可以自定义名字、性格、背景,甚至通过上传一张图片或一段视频,系统就能快速生成真人的“数字分身”。

我们制作的数字分身

此外,配合RAG文档导入功能,你还能给数字人“赋予灵魂”——比如导入客服文档,它就是金牌客服;导入个人笔记,它就是你的专属分身。这个功能可广泛用于内容创作、智能助手、在线教育、虚拟面试、客户服务等多种场景。

目前,“小麦”的核心能力已全面开放,开发者可前往摩尔线程文档中心获取云端API和本地SDK,基于这一方案开发出更多创新的多模态应用。

AI助手如果说“小麦”展示了交互的未来,那么内置的AI助手则务实地解决了当下的效率问题。

AIBOOK内置的AI助手,默认有端侧的Qwen3-8B模型以及云端的MUSAChat-72B和豆包模型,还能自行添加第三方大模型API,是用户一上手就能使用的功能,赋予设备灵活强大的AI能力,轻松应对多样化的应用场景。

除了基础对话,AI助手更像一个“AIGC工具箱”,还能调用多种在线AI工具,包括智源悟界Emu3.5和摩笔马良,支持高质量的文生图创作。而摩音笔记则是语音识别的AI工具,可以帮你快速转写,并同步生成录音与文字纪要。AI PPT则只需要输入主题内容即可智能生成PPT文档。

从文字处理到图像生成,再到办公文档制作,AIBOOK几乎覆盖了日常办公的所有AI需求,这AI助手功能还蛮齐全的。

基准性能测试体验完AI能力,我们回归硬件本质,看看支撑这些体验的基础数据。

能跑的测试中,大家比较熟悉的应该就Geekbench了,跑的是Geekbench 6.5.0的LinuxARM预览版,只能测试CPU的性能,可以看到长江SoC的单核得分为1096,多核得分为7308。

图形性能方面,我跑的是Glmark2,这是一个基于OpenGL ES 2.0的轻量级GPU测试工具,广泛用于嵌入式/ARM Linux,MTT AIBOOK在这测试中得分为6202。

Babylon.js是最流行的开源Web 3D引擎之一,是由微软主导开发,它基于WebGL和WebGPU标准,能够让浏览器基于页面实现精致的3D画面实时渲染,是目前最成熟、易用的选择Web 3D之一。在TypeScript测试中平均帧率是20fps。

在Javascript的测试中,我们把Rebuild Hex Grid:size设置为10,平均帧率为27fps。

多系统融合:一本多用,打破边界MTT AIBOOK所搭载的MT AIOS,虽然是基于AI开发首选的Linux内核,但作为主力生产力工具,单一Linux生态难免存在局限性。为此,AIBOOK通过先进的虚拟化与容器技术,巧妙实现Windows、Android与Linux三大系统无缝切换。

在虚拟机安装完成后,我们在AIBOOK上成功运行Windows 11。得益于领先的GPU虚拟化技术及对DirectX 12的完整支持, AIBOOK可以在虚拟化的Windows 11实现各种GPU加速功能,有效提升系统流畅度。

实测发现,在Linux下用虚拟机运行Windows 11效率其实还蛮高的,我们跑的镜像还是x86版的Windows 11 25H2,基本上运行各类桌面软件都没有问题,完美填补了Linux生态的空缺。

以影音娱乐为例,PotPlayer能够正确开启摩尔线程的GPU硬件加速,流畅播放各种高清电影。此外,开发者在Linux上弄出的AI应用其实也得在Windows上进行测试,毕竟终端用户的环境大部分还是Windows,能直接在本机上进行测试还是方便许多,这种“本机闭环测试”的能力极其实用。

Android生态的兼容,则是通过安装Android容器实现。用户可以在PES控制中心的“应用汇”程序,下载各种安卓应用,这拓展了AIBOOK的娱乐体验。无论是刷抖音、小红书,还是运行各类移动端游戏,体验都非常流畅。上面的截图就是我们在AIBOOK上运行《王者荣耀》,长江SoC的GPU性能对于安卓游戏来说完全就是从从容容游刃有余。

针对《原神》这类游戏,也能正常运行,需要注意的是游戏默认只能用鼠标操作,需要同时按下“Alt+Super+~”键切换到键盘模式才能使用映射的键盘按键。

MTT AIBOOK并非简单的系统堆叠,而是构建了一个丰富的生态闭环:

从开发层面——Linux主系统用于核心开发,高性能Windows虚拟机用于特定测试,Android环境用于移动端验证。

从日常维度——Linux搞开发,Windows日常办公,Android玩娱乐。

外观介绍

MTT AIBOOK采用十分简约的包装,基本上就是一个白色的盒子,上面写着“AIBOOK”,左边的明显是个数字人,让人一眼就联想到这款产品与AI有关。

MTT AIBOOK的A面采用极致简洁的经典造型,只有中间印有摩尔线程的Logo,机身采用6系列高强度耐腐蚀铝合金,使用全CNC工艺0.15mm高精度切割线条打造一体成型机身,表面采用超细目喷砂加阳极氧化处理工艺,触感细腻,也不容易沾上指纹。机身前方屏幕与键盘接触位置开有凹槽,用户可以从这里轻松打开屏幕,转轴是隐藏式的,在外侧基本看不到,出风口也隐藏在转轴位置。

搭载14英寸2880*1800的OLED屏幕,采用120Hz高刷新率,最大亮度500nit,支持10bit色深及100% DCI-P3广色域,实现精准生动的视觉呈现。设备配备4阵列麦克风提升人声拾音精度确保流畅的人机交互,结合4超线性扬声器系统,带来层次分明且富有张力的音频体验。

C面是全尺寸低噪音键盘,采用人体工学曲面键帽与1.2mm精调键程,输入触感柔和舒适,有效缓解长时间使用的手部疲劳。键盘支持三档可调白色背光,无论在何种光线环境下皆可清晰输入。触控板的尺寸相当之大,采用玻璃基表面,触控丝滑精准,支持多点手势操控,双指缩放、三指切换、四指调出任务栏均可轻松实现。

机身左侧有一个USB 5Gbps Type-C接口和一个3.5mm二合一音频接口,机身右侧则有两个USB 5Gbps Type-C口, 所有接口都支持给机器充电,但只有右侧的两个接口是全功能口,支持视频输出,充电指示灯也布置在机身右侧。

MTT AIBOOK采用无开孔一体式底面设计,D面就是一整块铝合金,那么它的散热和扬声器开孔在哪里呢?其实就藏在机身侧面,这里机身边框与D面之间有一条开孔,散热器的进风口与扬声器就藏在这里面,机身两侧都有这设计,就这样原本位于机身底部的开孔被移动到机身侧面了,这确实是一个相当巧妙又美观 的设计。

配送的充电器是100W的USB Type-C PD快充,有一根相当长的C2C线,机器的净重是1.47kg,旅行重量1.67kg,整体重量不高,相当便携,而且这充电器在不使用AI BOOK时也能给手机和其他设备充电,十分便利。

MTT AIBOOK机身上只有3个USB Type-C口,用起来其实不是很方便,所以摩尔线程还送了一个USB扩展坞,它可扩展出三个USB 5Gbps Type-A口,顶部还有一个HDMI视频输出口,这样写代码时就不用只盯着那个14英寸的小屏幕看了,说真的这个对开发者来说非常重要。

扩展坞上的USB Type-C是用来接充电器的,这样就只占用笔记本上的一个USB口就能同时扩展出三个USB Type-A口和一个HDMI口,同时还能给笔记本充电,但需要注意的是只有笔记本右侧的两个USB口才支持视频输出。

机器拆解

拆开MTT AIBOOK的底盖,可以看到摩尔线程这波在散热上可是下了重本,这台轻薄本居然用了大面积的均热板散热器,配备7752mm2的超薄真空腔均热板与双涡轮风扇,可快速导出核心热量并高效排出机身。风扇支持智能启停,在低负载时会停转,确保机器在大部分时候可以安静运作。

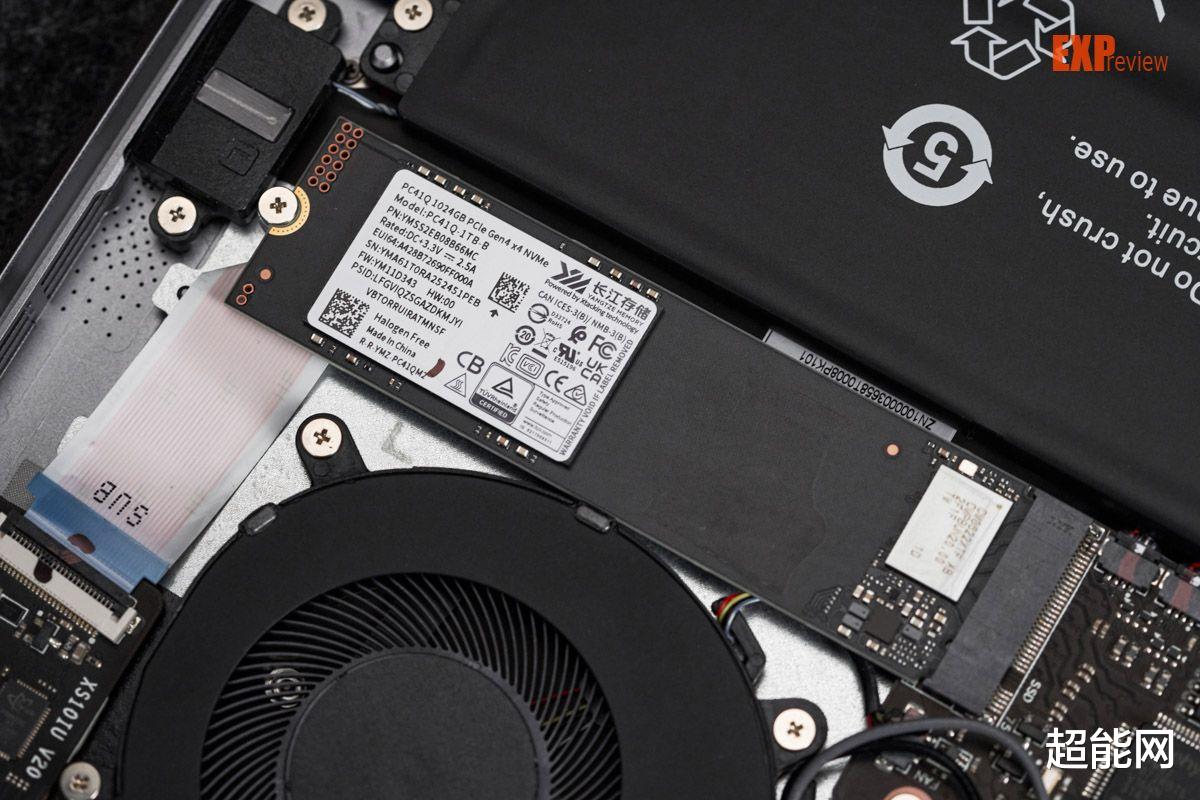

所配的SSD是长江存储的PC41Q 1TB,这款SSD在笔记本上很常见,Q就是QLC的意思,它采用长江存储第四代QLC 3D NAND闪存X3-6070,连续读写速度能到5700/5500MB/s,是一款性能还不错的QLC SSD。

无线网卡是AzureWave的AW-XB547NF,里面用的是Realtek RTL8852BE芯片,支持WiFi 6和蓝牙5.2。

内置的电池容量为70Wh

全文总结

我们测试这台MTT AIBOOK所用的时间比其他产品长得多,所以实际体验也挺深的,其实摩尔线程对这台AIBOOK的定位确实是对的,它就是面向AI学习与开发者打造的个人智算平台。首先就系统来说,对于普通消费者而言,Linux系统的学习和使用成本较高。但对于AI开发者来说,Windows其实并不好用,Linux才是更好的选择。

更重要的是,摩尔线程给这台AIBOOK预装了大部分AI开发所需要的东西,内置Python、VS Code、Jupyter等一整套主流AI开发工具,而且还预装了PyTorch、vLLM、Pandas、Matplotlib、Numpy和Ollama等常用库,支持Docker,解决了AI开发所需的环境配置问题。虽然还有些东西需要自己装,但基本上就是拿到手就能用,对于开发者来说十分便利。而且AIBOOK还是一台把Linux、Windows、Android三大操作系统整合一身的设备,在Linux上跑不了的东西可以在另外两个系统上运行,为这台设备增添了娱乐属性。

实际上,摩尔线程推出MTT AIBOOK的重要目标之一,就是面向AI开发者群体推广其自研的MUSA生态系统。AIBOOK不仅是一个软硬一体的全栈技术平台,更是开发者无缝接入MUSA生态的核心入口。通过提供“开箱即用”的开发体验,AIBOOK能够有效降低门槛,吸引高校、科研机构及开发者采用MUSA工具链,从而加速扩大其生态用户基础。可以说,MTT AIBOOK不仅是一款硬件产品,更是摩尔线程生态战略的关键载体——它致力于构建一个易于上手、性能可靠且与主流AI框架良好适配的开发环境,以吸引开发者长期投入MUSA平台,进而推动国产GPU与AI软件生态的可持续发展。