1月27-30日郑州,TsingtaoAI专家技术团队为某算力基础设施服务商交付NV智算集群技术实训。实训以英伟达H20服务器(8卡/台)和InfiniBand网络为核心,系统梳理硬件选型(H100 vs H20算力成本对比)、网络拓扑设计(Rail-optimized架构与万卡集群收敛比优化)、存储加速(GPUDirect Storage直连NVMe、多级缓存体系)等关键环节。重点突破NCCL通信库调优(Ring+Tree混合算法、LL128协议参数优化)、容器化部署(NVIDIA Container Toolkit深度集成)、及集群稳定性验证(72小时负载测试+故障注入模拟)。

针对行业高频痛点,深度解析“GPU利用率虚高”背后的内存带宽瓶颈、光模块失效的带内监控预测,以及国产昇腾/海光与NVIDIA混合组网的生态适配难题。通过Blackwell架构演进、MFU量化分析等前沿实践,将验收标准与实际运维场景深度结合,助力一线工程师从交付执行者向架构决策者跨越。

实训时长:4天,每天7小时

模块一:网络架构与技术栈

智算集群整体架构认知

计算集群的发展与挑战 (传统数据中心 vs 智算中心的本质差异 )

基于 NV 的L0集群基础建设介绍(AI 服务器节点、风冷液冷,服务器机柜)

大模型训练对基础设施的特殊要求(周期性爆发写入、低延迟通信)

1.2 NV算力资源的网络关键技术

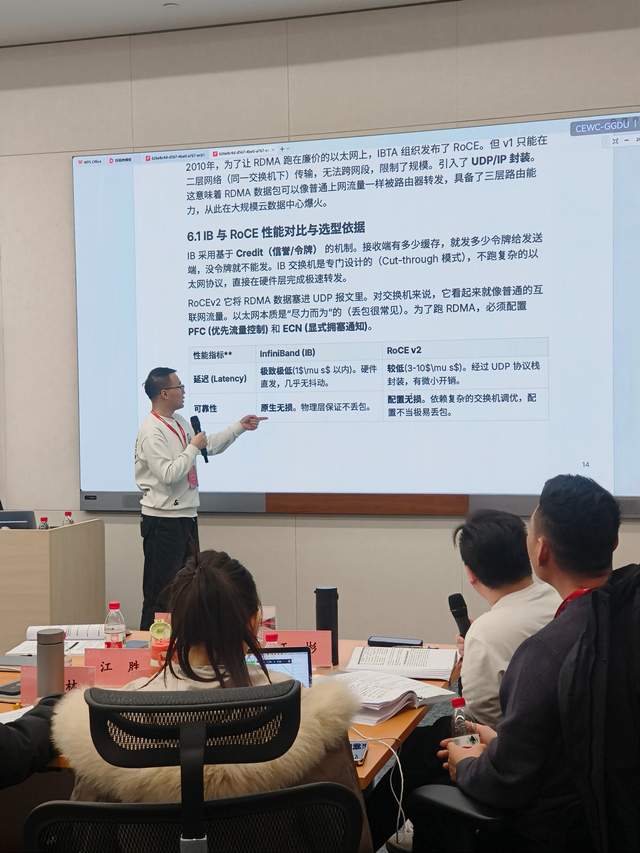

InfiniBand vs RoCE:性能对比与选型依据(带宽、延迟、丢包容忍度)

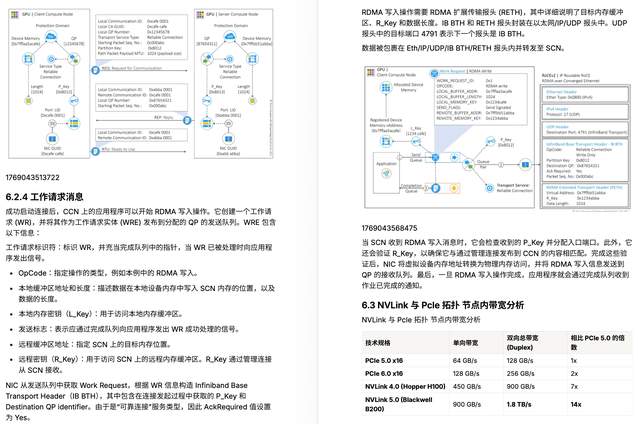

RDMA技术原理:零拷贝、内核旁路如何提升效率

NVLink、PCIe拓扑:节点内GPU互联的带宽瓶颈分析

PFC(优先级流控)与ECN(显式拥塞通知)配置要点

模块二:组网设计与实战

1.3 网络拓扑设计

Rail-optimized拓扑 vs 传统Spine-Leaf的区别

万卡 AI 集群建设挑战、交付与测试

NV Blackwell 与 NVL72 超节点演进(集群与互联)

案例: xAl十万卡集群的组网方案

1.4 实验1:集群性能分析与测试

环境准备:配置IB网卡IP、验证RDMA功能

使用ib_write_bw/ib_read_bw测试双向带宽

使用perftest工具验证延迟指标

对比TCP vs RDMA的性能差异

动手目标:理解RDMA的性能优势,掌握基础测试工具

Day 1下午:存储架构与GPUDirect技术模块三:存储需求与架构设计

2.1 大模型全流程的存储需求

训练阶段:数据集加载(TB级顺序读)、Checkpoint保存(周期性爆发写)

推理阶段:模型参数加载、KV Cache的内存-存储协同

存储性能三要素:IOPS、带宽、延迟的权衡

痛点分析:大模型 CKPT优化手段

2.2 高性能存储架构设计

训练存储优化方案与训练流程的存储分析(数据湖与存储加速)

训练数据加载与存储优化与存算架构的思考

GPUDirect Storage:绕过CPU直接访问存储的原理

多级缓存体系:内存-NVMe-并行文件系统的数据流设计

模块四:存储性能测试

2.3 实验2:本地存储与缓存优化

NVMe性能测试:FIO工具模拟顺序读写、随机IOPS

配置tmpfs作为训练数据缓存层

使用GPUDirect Storage API加速数据加载(模拟场景)

监控工具:iostat、nvme-cli的使用

2.4 案例研讨:存储瓶颈排查

实际案例1:训练启动慢,如何定位是网络还是存储问题?

实际案例2:Checkpoint保存导致训练卡顿的优化方案

小组讨论:如何设计存储架构应对碎片化读写?

Day 2上午:集群建设实战与自动化部署模块五:千卡集群交付流程

3.1 硬件选型与规划

GPU选型:A100 vs H100 vs H20的算力/功耗/成本对比

网络设备选型:IB交换机的端口密度、收敛比计算

服务器配置:CPU/内存/NVMe的配比原则

3.2 集群建设全流程

需求分析→方案设计→硬件到货→上架布线→系统安装→功能验证

硬集与软集的区别:物理组装 vs 软件配置的职责划分

痛点:如何避免硬件批次差异导致的兼容性问题?

案例:某千卡集群交付复盘

模块六:自动化部署

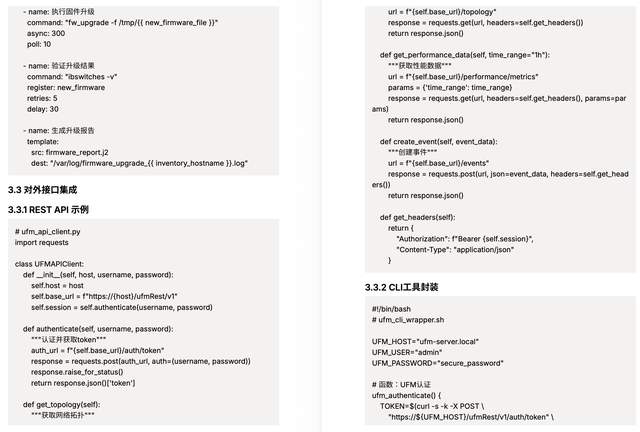

3.3 IB网络自动化配置

拓扑发现:使用ibnetdiscover生成网络拓扑图

自动化工具:Ansible Playbook批量配置IB参数

UFM架构与功能

软件架构:管理节点+Agent部署模式

核心功能:拓扑可视化、性能监控、固件升级

对外接口:REST API、CLI、Prometheus集成

3.4 实验3:IB网络配置与UFM监控

手动配置IB子网管理器(OpenSM)

使用ibdiagnet诊断链路状态

演示UFM界面(视频/截图,受限于无交换机)

编写Ansible脚本批量修改MTU、速率等参数

动手目标:掌握IB网络的基础运维命令

Day 2下午: NCCL通信库与性能优化模块七:NCCL原理与调优

4.1 NCCL通信原理

集合通信操作:AllReduce、AllGather、ReduceScatter的区别

NCCL的通信算法:Ring、Tree、Ring+Tree的适用场景

通信协议:Simple vs LL vs LL128的性能差异

原理图解:单机8卡AllReduce的数据流向

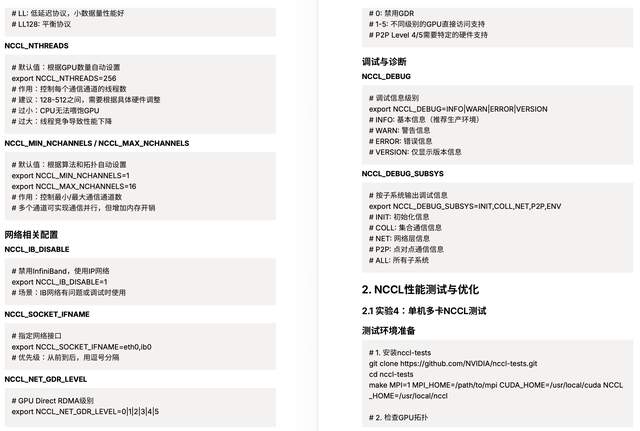

4.2 NCCL环境变量详解

核心变量:NCCL_ALGO、NCCL_PROTO、NCCL_NTHREADS、NCCL_MIN_NCHANNELS

网络相关:NCCL_IB_DISABLE、NCCL_SOCKET_IFNAME、NCCL_NET_GDR_LEVEL

调试变量:NCCL_DEBUG、NCCL_DEBUG_SUBSYS

模块八:NCCL性能测试与优化

4.3 实验4:单机多卡NCCL测试

使用nccl-tests测试单机8卡AllReduce带宽

对比NVLink vs PCIe的通信性能

调整NCCL环境变量观察性能变化

使用nsys/Nsight Systems分析通信瓶颈

常见问题:GPU看得到但NCCL初始化失败的排查思路

4.4 疑难问题研讨

问题1:网络不丢包,但AllReduce带宽达不到设计值

排查思路:检查NCCL_ALGO、确认IB链路状态、验证GPU拓扑

问题2:GPU利用率90%+但训练慢

分析方法:区分计算bound vs 通信bound vs IO bound

Day 3上午:模型部署与训练实战5.1 大模型训练任务和推理任务的混跑的碎片化解决方案

分层解决方案(技术栈)

第一层:硬件与系统级隔离

第二层:运行时级调度与抢占

第三层:框架级优化与自适应

一个典型的混合部署策略示例

5.2 训练出错,快速判断算法问题还是硬件问题的一站式解决方案

硬件问题的典型特征

算法/代码问题的典型特征

系统性排查步骤(实战流程)

5.3 如何处理慢节点拖累整个集群的问题?

短期应急(止血) 重启任务/节点

中期优化(治标) 资源隔离与保障

长期预防(治本) 建立硬件健康度基线

5.4 GPU 利用率“看起来很高”,但训练效率依然很低,nvidia-smi 显示 GPU Util 90%+,实际每 step 时间明显偏慢

内存带宽瓶颈(最常见)

现象:计算强度低,GPU大部分时间在访存而非计算

低效内核或过多小内核

现象:大量微小操作,内核启动开销占主导

NVLink瓶颈(数据加载/通信)

现象:数据从CPU到GPU传输成为瓶颈

动态/条件执行(分支发散)

现象:存在大量if-else、不同长度的序列处理

显存竞争/频繁分配释放

现象:大量临时张量创建和销毁

PyTorch/TensorFlow特定问题

常见陷阱:torch.no_grad()缺失导致保留计算图

.item()、.cpu()等同步操作

非必要地频繁调用.cuda()

自动混合精度(AMP)配置不当

系统化排查步骤

模块九:容器化部署

5.5 容器环境搭建

Docker vs Singularity/Enroot在HPC场景的选择

NVIDIA Container Toolkit原理:如何让容器访问GPU

镜像构建:基础镜像+CUDA+PyTorch+训练代码的层次

网络命名空间:容器内如何使用宿主机IB网络

5.6 实验5:容器化部署大模型

拉取NGC官方PyTorch镜像(离线环境需提前准备tar包)

编写Dockerfile安装依赖(transformers/flash-attention等)

使用docker run启动容器并挂载数据集

运行某小尺寸模型测试训练流程

动手目标:掌握生产级容器启动命令的编写

模块十:单机多卡训练

5.7模型训练实战

使用torchrun启动多卡训练(DistributedDataParallel)

监控工具:nvidia-smi、dcgm-exporter实时查看GPU状态

训练日志分析:loss曲线、吞吐量(samples/s)、MFU计算

常见错误:CUDA OOM、通信超时的快速定位

5.8实验6:单机8卡模型训练

运行某小尺寸LLM预训练任务(尺寸视内存而定)

调整batch size/gradient accumulation观察显存占用

使用tensorboard可视化训练曲线

性能对比:单卡 vs 8卡的加速比分析

挑战任务:尝试开启混合精度训练(AMP)

Day 3下午:集群测试与验收标准模块十一:基线性能测试

6.1 测试方案设计

测试维度:计算性能、通信带宽、存储IOPS

测试工具链:

GPU计算:CUDA Samples、cuBLAS benchmarks

网络:nccl-tests、ib_write_bw、SHARP测试

存储:FIO、IOR

验收标准制定:如何设定合理的性能基线?

6.2 实验7:GPU基线性能测试

运行CUDA Samples中的bandwidthTest、deviceQuery

使用HPL/HPCG测试峰值算力

GPU Burn压力测试:长时间满载运行检测稳定性

静默错误检测:使用dcgm-diag的诊断功能

记录:整理测试数据形成测试报告模板

模块十二:稳定性与故障注入

6.3 稳定性测试方法

长时间负载测试:72小时连续训练任务

故障注入:模拟GPU掉卡、网络抖动场景

MFU(Model FLOPs Utilization)测试:计算有效算力利用率

6.4 案例研讨:故障排查实战

案例1:训练中途loss突然变NaN,如何判断是算法还是硬件?

案例2:慢节点拖累全局,如何快速定位异常节点?

小组讨论:制定自己的故障响应SOP

Day 4上午:生产环境运维与高级调优模块十三:运维工具与监控

7.1 运维工具体系

UFM深度实践:

部署架构:HA模式、数据库选择

监控指标:链路流量、错误计数、温度/功耗

告警配置:如何设置阈值避免误报

API集成:通过REST接口对接运维平台

DCGM(Data Center GPU Manager):

架构:Host Engine + Agent模式

健康检查:周期性诊断GPU状态

与Prometheus/Grafana集成实现可观测性

7.2 实验8:运维工具部署与监控

部署DCGM并配置Exporter

编写Grafana Dashboard展示GPU指标

模拟故障:拔掉光模块观察UFM告警(视频演示)

使用dcgmi命令行工具查询GPU健康状态

智算中心光模块故障率高,如何通过带内监控提前预测光模块失效

动手目标:搭建一套可用的监控系统

模块十四:混合调度与高级话题

7.3 资源调度与隔离

Slurm vs Kubernetes在AI集群的适用性

GPU共享与MIG(Multi-Instance GPU)技术

训练任务(独占) vs 推理任务(零散)的资源隔离策略

痛点:碎片化问题如何通过调度器解决?

7.4 国产芯片混合组网

华为昇腾、海光与英伟达的生态差异

混合算力中心架构设计:网络隔离 vs 统一调度

挑战:驱动版本管理、框架适配的复杂度

7.5 推理架构设计

并行策略:Tensor Parallelism vs Pipeline Parallelism

Prefill-Decode分离架构

推理框架:vLLM、TensorRT-LLM、FasterTransformer对比

案例:如何实现毫秒级推理延迟

Day 4下午:交付验收与综合实战模块十五:验收标准与实操

8.1 交付验收流程

验收文档模板:测试清单、性能报告、问题跟踪表

功能验收:计算/网络/存储各模块Checklist

性能验收:基线对标、SLA达标确认

文档交付:运维手册、故障处理手册、培训材料

测试用例

建设完成后,如何验证网络性能?

计算并验收模型算力利用率

8.2 实验9:模拟验收测试

按照标准流程执行全套测试:

GPU计算性能

NCCL通信带宽

存储IOPS

模型训练端到端

填写测试报告

角色扮演:分组模拟甲方-乙方验收场景

模块十六:综合答疑与总结

8.3 疑难问题集中解答

重点解答学员提交的问题(结合前7天内容)

重点问题深度剖析:

光模块故障预测(带内监控、DOM数据分析)

链路性能下降对训练的影响量化

版本管理最佳实践(容器化+版本锁定)

8.4 课程总结与展望

知识体系回顾:从硬件到软件、从建设到运维的完整链条

推荐学习资源:NVIDIA官方文档、开源社区、行业白皮书

职业发展建议:从实施工程师到架构师的成长路径

8.5 结业考核

涵盖关键知识点(20题选择+5题简答)

实验资源准备清单软件环境(需提前准备离线安装包):

操作系统:Ubuntu 22.04 LTS

CUDA Toolkit 12.2 + cuDNN 8.9

NVIDIA Driver 535+

Docker/Containerd + NVIDIA Container Toolkit

PyTorch 2.1 + transformers

NCCL 2.19+、nccl-tests、OpenMPI

监控工具:DCGM、Grafana、Prometheus

测试工具:ib_write_bw、FIO、HPL

小模型:若干小尺寸模型及权重

部分实训课件

北京邮电大学,网络与交换国家重点实验室,计算机科学与技术硕士。某互联网大厂高级工程师,深度学习框架开发与性能调优专家horovod,spark,iceberg,hudi 等系列源码贡献者,AI大模型+AI Infra公众号“Tim在路上”主理人。

专业能力

熟悉深度学习框架,模型性能调优,有过深度学习框架开发调优经验。

熟悉 GPU, NPU, CUDA, CANN, Nccl, IB 等底层原理与工程实践。

熟悉数据湖/数据引擎的开发优化,例如针对SparkSQL 源码级优化开发。

熊老师 AI技术专家中国农业大学计算机硕士,研究员高级工程师,华为云AI专家组成员,西安电子科技大学企业导师,浙江大学人工智能中心研究员,阿里云AI训练师认证教材和题库系统专家,主要研究方向为大语言模型、人工智能、云计算、GPU算力运维与调优、自然语言处理、CV视觉模型、汽车智能驾驶。从早期的智能搜索引擎,到华为盘古大模型云引擎研发,到阿里云百炼智能平台应用开发,再到扣子平台智能体应用开发,一直深耕于自然语言处理处理、AI大模型领域。

华为培训中心资深IT认证培训专家,国内顶级架构设计、软件开发专家。具有坚实的学术背景和教学培训经验,多年研发和客户项目高级管理咨询能力。近20年系统开发经验,5年以上授课经验。

在技术平台方面,主要是擅长培训两块内容:一是人工智能和大模型,精通整个体系的培训工作,包括Python语言,Python web,Numpy,Pandas,Matplotlib,爬虫,机器学习的十大算法线性回归,逻辑回归,逻辑回归,聚类,支持向量机,关联规则,协同过滤,深度学习的卷积神经网络,循环神经网络,长短期记忆,对抗学习,强化学习,大模型LLAMA,LLVM等引擎构建技术,以及最后的大模型应用案例实现。二是知识库、智能体和MCP应用,精通整个体系架构,包括提示词工程, LLM、LangChain等技术的开发与应用。深入理解智能体、工作流、语言助手等平台应用开发技术。对于大模型体系有深刻认识,及独到的见解。已经参与了数十个AI大模型应用项目研发,并主导系统设计和优化,有着丰富的大模型系统设计开发工作经验。

精研课程

人工智能机器学习算法

大模型训练

自然语言处理文本处理实践—文本自动摘要、文章自动生成

基于深度学习的知识图谱实战

基于深度学习的个性化推荐系统实战

DeepSeek提示词工程

基于DeepSeek的大模型微调技术

DeepSeek的RAG技术--知识库开发

阿里云人工智能训练师认证培训

基于Dify平台的智能体开发

Ollama+DeepSeek+Dify平台开发最佳实践

近期主要培训和咨询内容:

杭州阿里巴巴:2024年11月,12月,2025年2月,3月,4月,在阿里总部西溪园区进行。每期培训都通过5天的的AI训练师认证培训工作,培养阿里云生态内外的AI训练师以及师资,以实现阿里云百炼平台,QuickBI,QuickService 等多个AI平台应用的推广,提升学员的智能体开发能力。

四川移动:2024年11月,大模型知识库调优(九天大模型,ChaGPT,ChatDB),通过一周的技术实战培训,提升移动在线团队(10086)的语言助手智能水平,并将相关技术应用到了四川移动在线的内部平台。

宝马汽车:2024年12月,基于github copilot的AI编程开发技术应用,通过3天的技术实战培训,提升汽车软件开发团队的智能编程能力,并将微软云的智能编程工具接入研发团队的内部平台。

博世苏州:2025年1月,基于微软云AI编程开发工具技术,包括github copilot以及相关组件的应用,提升团队编程开发和软件测试的智能化水平。同时帮助团队将Azure接入团队开发的内部平台。

中国移动设计研究院:(2024年1月,3月,7月,12月,2025年4月等)大模型底层设计和优化。经过多轮培训和持续的咨询工作,采用基于GPU集群的算力,优化LLVM,LLAMA2在内的大模型引擎技术,提高了大模型引擎的稳定性和拓展能力。引入了去中心化集群技术和跨域资源调度技术,提高了大模型底层引擎的可靠性和可维护性。

除此以外,对上层的基于自然语言处理的大模型应用进行指导和应用。包括提示词的编写,文字和图片的生成,视频的生成等应用,优化生成资源的精准度,提升生成资源的速度,并开发与外部系统之间的接口,目前已有超过百种外部应用接入了大模型,显著提升了生产能力,大大超过客户了之前对此次培训和咨询的预期。

福州信产亿力公司:2025年4月25-26日,基于DeepSeek和Dify的智能体应用开发实践。包括平台搭建,智能体构建,提示词工程以及基于RAG的知识库构建应用。并将相关技术应用到智能办公和智能问答等方面。

北京中国民航开发中心(CAST):2025年4月,基于DeepSeek等大模型的AI编程技术开发。经过一个多星期的培训和咨询工作,提升了相关AI编程工具的使用能力,帮助客户构建了基于私有云的AI编程内部平台,从源头提升了研发生产力。

内蒙电力数字化和智能体应用:2025年5月下旬,经过10天的培训,帮助客户构建了基于office和WPS的私有大模型办公平台。除此以外,构建了基于一体机的Dify+DeepSeek+Ollama的智能体和直属库开发应用平台,提升企业内部数字化能力和自动化流程能力

关于TsingtaoAITsingtaoAI(北京霆涛商业智能技术有限公司)企业内训业务线专注于提供LLM、智算、具身智能、AIGC和数据科学领域的企业内训服务,通过深入业务场景的案例实战和项目式培训,帮助企业应对AI转型中的技术挑战。其培训内容涵盖AI大模型开发、Prompt工程、数据分析与模型优化等最新前沿技术,并结合实际应用场景,如智算中心、智能制造、医药健康、金融科技和智能驾驶等。通过案例式学习和PBL项目训练,TsingtaoAI能够精准满足企业技术团队的学习需求,提升员工的业务能力和实战水平,实现AI技术的高效落地,为企业创新和生产力提升提供强有力的支持。

同时,TsingtaoAI公司并不是一家单纯的培训机构,我们同样是一家AI产品和AI Infra开发公司,公司核心团队主要也都是由技术和产品人才构成,公司团队大部分成员在大模型时代之前就在从事AI相关的工作。公司在过去一年里,为10余家客户开发了AI相关的产品,涵盖医疗、教育、智能制造、人力资源等领域。相信我们在AI产品开发和客户服务的过程所形成的认知和方法论,能对贵司的需求有更深更细的洞察和理解,也能提供更深入业务肌理的“AI能力获得”。