当前,机器人智能化演进正处在一个微妙的十字路口。深度学习模型在图像识别、自然语言处理等领域取得了颠覆性成就,但机器人的物理交互能力,尤其是需要触觉、力觉反馈的灵巧操作,进展却相对缓慢。

一个根本原因在于,大多数用于训练的数据集高度依赖视觉。它们能告诉机器人物体“看起来”是什么样子,却无法传递“拿起来”是什么感觉——是光滑是粗糙,是坚硬是柔软,需要用多大力度,如何调整抓取姿态。

要让人形机器人真正胜任家庭服务、物流分拣、精密装配等复杂任务,就必须为其注入真实的“触觉记忆”与“肌肉记忆”。乐聚机器人开源的800条灵巧操作数据集,正是直击这一痛点。它并非在简化、理想的仿真环境中生成,而是全部源于在家庭、物流、日化三大核心场景下的真实作业,提供了从视觉到力触再到动作的完整、连续、多模态学习样本。

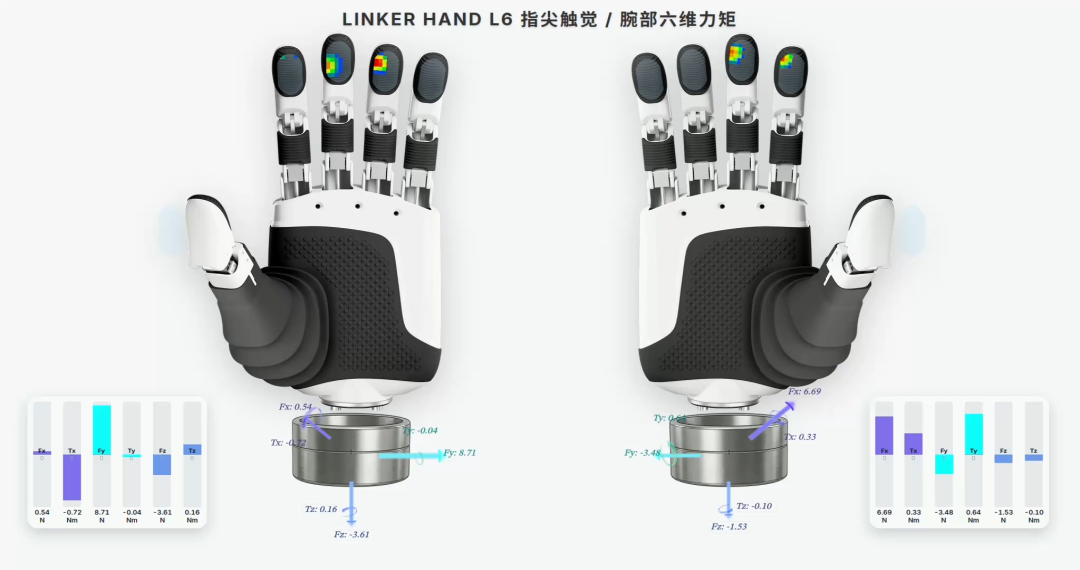

灵巧操作数据集的核心突破在于触觉与力觉数据的引入。

数据集中包含五大核心维度:

触觉阵列数据:采用6×12×5指尖触觉传感器采集时序压力数据,能精准反映物体材质、形状和接触状态变化。

六维力数据:记录抓取、放置等动作的三维力和力矩信息,测量精度达到±0.5%。

RGB-D视觉数:据提供高分辨率彩色图像和稠密深度图,完整还原操作场景的外观特征与三维信息。

同步动作信息:则配套记录手部关节角度、速度等参数,实现了“视觉-力触-动作”的全链路对齐。

多场景标注:涵盖快递分拣、快消上料、家庭物品抓取等典型任务,每条数据均附带场景类型、物体材质、操作目标等多维度语义标签,支持自然语言与动作对齐建模。

家庭场景稳定抓取水果

快消场景无损放料

快递场景高效分拣

03 硬核技术,筑牢数据质量根基

高质量数据的产出离不开底层硬件技术的支撑。此次开源数据集基于乐聚新一代全感知灵巧手统一采集,有效避免了因设备差异导致的数据偏差问题。

这款灵巧手融合了实时力觉反馈与指尖触觉感知技术,所有数据均来自真实场景的精细化操作任务。其性能指标亮眼:关节速度达160–185°/s,开合响应时间仅0.35秒,定位精度±0.2毫米。

配合触觉和力传感系统,灵巧手能够同步采集物体特征和力度数据,完整记录精细操作全过程。凭借这些优势,它已在多场景验证中展现卓越能力——

家庭场景中稳定抓取水果、纸杯;快消场景中无损抓放各类物料;快递场景中高效分拣包裹。这些真实操作产出的数据,自然具备高感知精度和实际应用价值。

纸箱拆垛

快递分拣

04 效能跃升,从“看得见”到“操作得准”

优质数据集直接驱动机器人模型训练效能与实用性的双重提升,推动机器人能力从“看得见”向“操作得准”跨越。这一价值已在多个真实场景中得到验证:

任务成功率大幅提升,在纸箱拆垛、快递分拣等场景中,机器人任务成功率显著提高。基于多模态感知能力,机器人能实时感知物体状态和操作力度,即使面对条码遮挡等复杂情况,也能通过触觉补偿实现精准操作。

环境感知也更为全面,该数据集为力控策略优化、触觉-视觉融合模型提供了坚实的数据支撑,打破纯视觉局限,构建稳定的物理交互闭环,显著增强复杂环境下的操作稳定性,动态调整抓取姿态和力度,避免包裹滑落或纸箱破损。

研发门槛随之降低,配套的数据工具包和示例代码开箱即用,大幅缩短研发周期,加速技术从实验室走向产业应用的步伐。

模型泛化能力得到增强,数据集能支撑机器人适配不同材质、形态的物体,邮政包裹扫码、日化产品翻转等场景验证了这一点。同时,它还能为具身大模型提供真实数据,助力突破“仿真-现实”鸿沟,为前沿研究持续赋能。

乐聚机器人此次的开源探索,不仅展现了其在人形机器人领域的技术硬实力,更向行业输出了标准化数据建设的实践经验。

随着数据集的持续完善与生态伙伴的协同共建,这一开放举措将进一步推动具身智能技术的迭代演进,助力产业高质量发展,为人形机器人的广泛应用铺平道路。