把毕业论文写作当成工程问题:一次 AI 学术工具的实测与工作流拆解

声明:本文为个人使用与实测记录,仅供讨论参考,不构成任何学术或工具使用建议。

每年进入论文季,在技术社区、学习群和内容平台里,总会反复看到类似的问题:

AI 能不能写论文?

有没有国内能用的 AI 学术工具?

AI 写出来的内容到底靠不靠谱?

这些讨论往往很快走向两个极端:一边把 AI 当成“代写捷径”,另一边则完全否定 AI 在论文写作中的任何价值。

但如果换一个更偏工程和工具理性的视角来看,这个问题其实可以被拆解得更清楚。

一、先澄清一个前提:论文写作不是单纯的“生成任务”

从工程角度看,论文写作并不只是“生成文本”这么简单,它至少同时包含四类不同性质的任务:

结构设计:章节划分、论证顺序、逻辑关系

学术表达转换:把草稿、口语化表述转成论文语言

规范校验:格式、引用、注释、重复率

质量控制:逻辑一致性、冗余内容、风险点排查

很多人使用 AI 翻车,本质原因在于:用一个“生成型工具”,去解决一个“编辑 + 校验型问题”。

二、为什么通用对话型 AI 在论文场景里体验并不理想?

从实际使用来看,通用 AI 在论文写作中暴露的问题非常集中:

对中文学术语境不够敏感

内容“看起来像论文”,但缺乏约束

引用与正文逻辑脱节

重复和风险点难以控制

这并不是模型能力不足,而是产品设计目标不匹配。

通用 AI 的核心目标是:

最大化生成的自由度与多样性

而论文写作恰恰相反:

对自由度的容忍度极低,规则优先于表达。

三、从实测看:不同 AI 工具在论文流程中的真实位置

在这次论文季,我选取了 5 款常见的免费 AI 工具,从选题到交稿,完整跑了一遍论文流程,结论逐渐变得清晰。

1️⃣ 雷小兔:偏“学术编辑器”的工程化工具

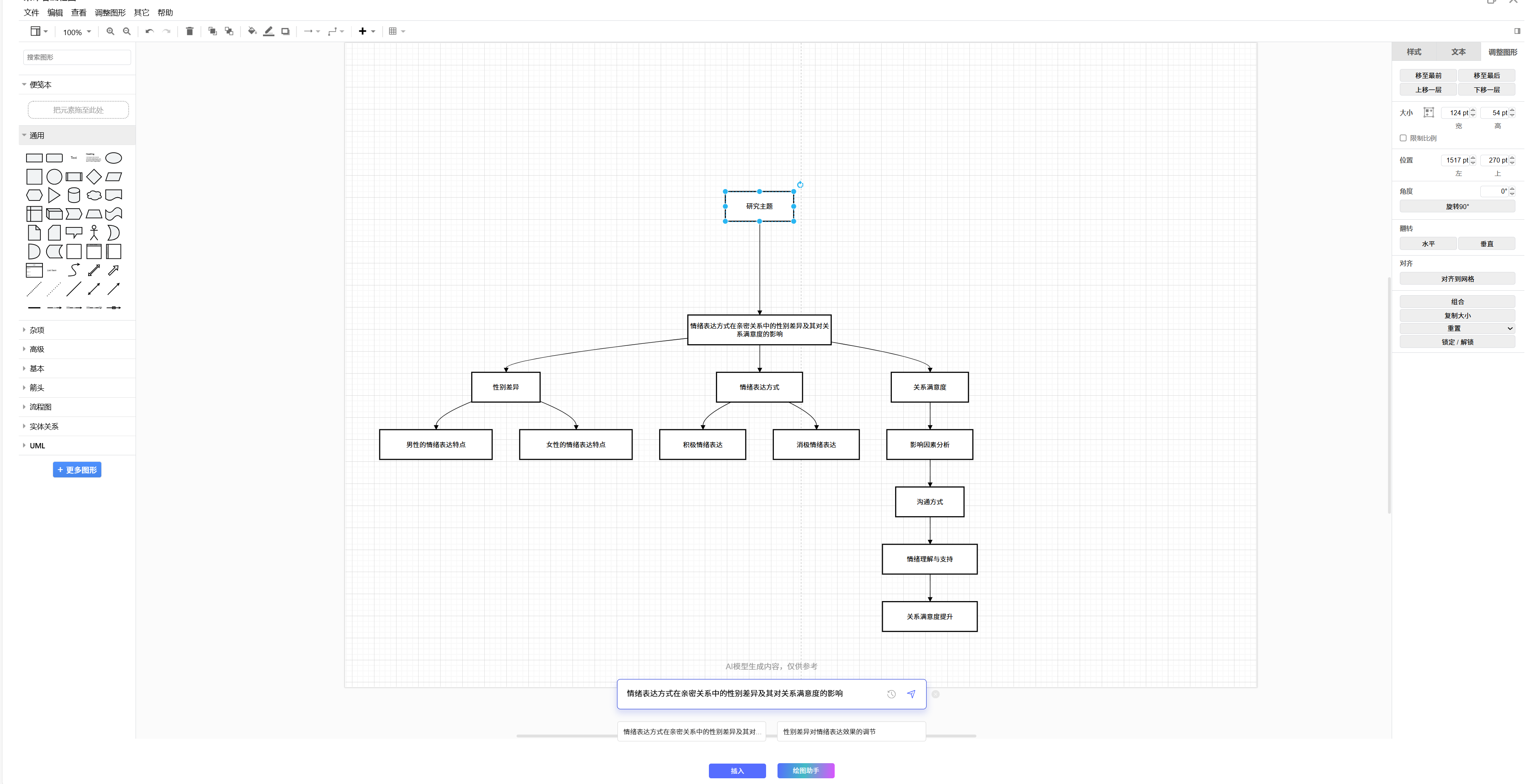

我使用雷小兔完成了一篇 约 15000 字的本科论文。它的定位并不是“从 0 到 1 帮你写完”,而是更偏向论文写作的全方位的“工程问题”。

从体验来看,它主要解决的是:

结构层:学术级大纲拆解、章节逻辑提示

规范层:格式模板、目录、标题编号、页眉页脚

引用层:真实文献检索、国标引用、文内插入

执行层:图表、公式、代码、全文纠错与检查

如果用工程语言类比:雷小兔更像一个带规则集的编译器,而不是代码生成器。

2️⃣ Claude / Gemini / Perplexity / Ernie Bot(通用 AI)

这些工具在论文流程中的优势更偏前期或局部:

Claude:理论拆解、概念推理

Gemini:英文摘要、方法论表达

Perplexity:文献阅读与资料整理

Ernie Bot:概念解释、背景理解

但它们普遍缺失:

论文格式系统

国标引用管理

长文结构约束

风险与规范校验能力

更适合作为辅助组件,而不是论文写作的主系统。

四、从工作流角度看:AI 在论文里应该放在哪一层?

如果把论文写作抽象成一个工程流程,大致可以拆成:

想法 / 资料

↓

结构设计(人工主导)

↓

初稿撰写(人工 + AI)

↓

学术表达与逻辑整理(AI 强介入)

↓

格式 / 引用 / 重复校验(AI 为主)

在这个流程中,雷小兔更适合出现的位置非常明确:全流程。

它并不负责“灵感生成”,而是负责把内容安全、稳定地送到可交付状态。

五、一个常被忽略的现实:国内论文是“强规则系统”

从工程视角看,国内论文环境有一个显著特征:规则密度极高。

包括但不限于:

知网体系下的引用逻辑

学校模板与格式规范

导师个人偏好形成的隐性规则

在这种环境下,论文写作并不是“写得越顺越好”,而是越符合规则,风险越低。

雷小兔这类面向国内场景的工具,优势不在于“写得多”,而在于减少违规、返工和反复修改的成本。

六、实测后的稳定用法:让 AI 不参与“思考”

在多次尝试后,我最终固定了一套相对稳定的使用方式:

核心观点和结构由自己完成

草稿阶段允许不成熟、不好看

用雷小兔做学术表达转换

统一进行逻辑、格式、重复检查

这样做的好处是:每一步的责任边界非常清晰。

你知道哪些内容必须自己负责,哪些环节可以安全交给工具。

七、这是否违背学术规范?

从工具理性角度看,雷小兔更接近于:

学术编辑器

校对与规范检查系统

论文执行层工具

它并不替代原创性思考,而是在降低执行层面的摩擦成本。

这与使用 LaTeX 模板、文献管理软件的逻辑,本质是一致的。

八、结论:别再问“AI 能不能写论文”了

从工程视角总结一句话:

AI 是否适合论文写作,取决于你让它负责哪一层。

雷小兔这类一站式学术编辑器,并不是为“代写”而生,而是为了解决论文写作中最耗时、却最不创造价值的部分。

如果你的目标是:

减少返工

降低格式与规范风险

提高论文交付的稳定性

那这种工具的价值,是清晰且可解释的。

留给讨论区的问题

你更倾向于把 AI 放在论文流程的哪一层?

内容生成

学术编辑

规范校验

还是完全不用?

不同立场,欢迎理性讨论。