从ChatGPT到Sora,国产大模型合适才能实现从跟随到超越的转变?

01

超26万人排队

国产文生视频大模型爆了

在大模型遍地的今天,一款新产品能获得超26万人排队的景象,注定其会在短期内成为爆款。

作为国内“首个面向用户开放的Sora级文生视频大模型”,截止2024年6月28日下午14时,“可灵”内测的排队申请人数超过26万人!

“可灵”是一款由快手AI团队自主研发的视频生成大模型,具备强大的视频创作能力。该模型采用了3D时空注意力机制和多项自研技术创新,能够生成符合物理规律的大幅度运动视频,并模拟真实世界特性。

从官方的介绍看,“可灵”大模型支持生成长达2分钟、30fps的1080p高分辨率视频,并且支持多种宽高比。此外,它还具备强大的概念组合能力和想象力,能够根据描述文字生成有复杂运动规律和物理特性的高质量AI视频。

目前,“可灵”推出了两项新功能:图生视频和视频续写功能。图生视频功能允许用户将静态图像转化为5秒钟的视频,用户可以通过提示词文本控制图像中物体的运动。视频续写功能则支持对已生成的视频进行一键续写和连续多次续写,最长可生成约3分钟的视频。

从官方公布的效果看,“可灵”的效果称得上逼近Sora,毕竟其最长可生成约3分钟的视频,是Sora的3倍。

Sora的发布不仅在技术界引起了巨大的反响,也对产业界和政府部门产生了深远的影响。许多企业和研究机构开始探索如何利用Sora来推动各自领域的发展,例如在广告、娱乐、教育等多个行业中寻找新的应用场景,其发布不仅展示了OpenAI在AI领域的领先地位,也为全球AI技术的发展和应用开辟了新的道路。

如今,国内AI厂商们在蓄力许久后,终于拿出了自己的AI视频生成模型。

"可灵"借鉴了Sora的技术框架,并融入了多项自主研发的创新技术,能精确模拟复杂的运动场景和物理特性,具有三大特征:高清视频生成与物理特性模拟、复杂运动场景建模与连贯性、先进技术架构与用户交互控制。

从行业的角度来看,快手作为头部短视频公司,其AI产品表现不仅展现了快手在AI大模型技术方面的深厚积累,也体现了国产AI视频模型的技术能力,提升了国产AI文生视频的发展信心。

而除“可灵”外,国内还有哪些AI企业在布局AI视频生成赛道呢?

02

清华团队下场

含着金钥匙出生的Vidu

2024年4月27日,中关村论坛未来人工智能先锋论坛上,北京生数科技有限公司联合清华大学发布了中国首个长时长、高一致性、高动态性视频大模型,其采用了团队原创的Diffusion 与 Transformer 融合的架构 U-ViT,该架构不采用插帧的多步骤处理方式来生成视频,而是通过单一步骤“端到端”直接生成内容,从文本到视频的转换是直接、连续的。

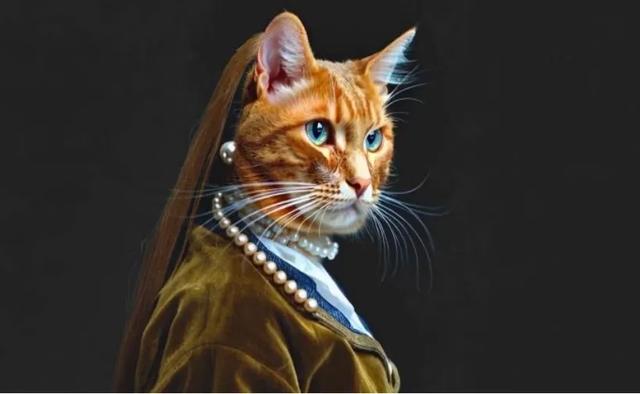

Vidu 能够一键生成长达 16 秒、分辨率达到 1080P 的高清视频内容,其拥有丰富的想象力,可以模拟真实物理世界中细节复杂且符合物理规律的场景,例如合理的光影效果、细腻的人物表情等,还可生成具有深度和复杂性的超现实主义内容(例如“戴珍珠耳环的猫”)。

Vidu官方演示视频之“戴珍珠耳环的猫”,想象力较高

北京生数科技有限公司成立于2023年3月6日,核心成员主要来自清华大学人工智能学院其首席科学家朱军为 |EEEFellow、清华大学计算机系教授与人工智能研究院副院长、清华智能技术与系统国家重点实验室主任。此外,公司的 CEO 唐家渝是 THUNLP 组成员,CTO鲍凡长期关注扩散模型领域研究并主导了 U-ViT 和 UniDiffuser,其均为人工智能和扩散模型领域有着深厚研究的专家,此外还汇集了来自阿里、腾讯、字节等知名科技公司的顶尖人才。

强大的技术团队实力和众多大佬资金支持,让Vidu面世后就走上快速进化的道路。

2024 年1月,生数团队实现4秒视频的生成,已可以达到 Pika、Runway的效果,至3月底实现8秒视频生成,4月实现16秒视频生成,在3个月内生成时长提升至4倍,且据4月27日中关村论坛中生数领军人朱军的发言,Vidu 会以更快的速度迭代,与Sora 差距将越来越小。

相比于 Runway,Vidu 生成视频的运动幅度更大。除 Sora 外,目前文/图生视频较难做到让人物做出复杂动作,因此为了保证画面畸变最小,视频生成的策略为选择小幅度的运动,较难设计复杂动作,难以处理场景和人物的一致性问题。目前Sora 在视频生成中领先较多在除 Sora 外,Vidu 在保证了时空一致性的前提下运动幅度较大。

AI生成视频的一大困难是时间的连贯性,目前龙头Sora能记住视频中的人和物体,在其被暂时挡住或移出画面后依然能按照物理逻辑地让视频保持连贯性。而Vidu公布的演示视频中具有多镜头的视频,其展示了较高的连贯一致性。

在技术方面,生数团队的Vidu模型使用 U-ViT 架构,具备多模态、效果好、成本低等优势。

ViT 基础架构流程图

U-ViT 是生数科技团队设计的一种简单通用的、基于 ViT 的架构,使用 Diffusion 生成图像,打响了扩散模型中 CNN 被 Transformer 取代的第一枪。模型首先对输入图像进行分割处理(分割为patch),与时间和条件一道表示为 token 后通过 Embedding 层,随后经过 Transformer Block 后输出为 token,并通过一个线性层转为图块,最后通过一个可选的 3X3 卷积层输出为最终结果。此外,U-ViT 成本优势大幅领先,主要得益于ViT 架构的训练成本较低。

03

拥有抖音经验的PixVerse

在国产AI视频领域,另一款大火的模型PixVerse则是由爱诗科技开发,虽是一家创业企业,但爱诗科技“技术传承路线”同样可圈可点。

爱诗科技由前字节跳动AILab 总监王长虎创立,在字节跳动工作时,王长虎和其团队在为抖音构建视频 AI能力的过程中积累了数据处理、内容生产、安全问题处理、视频内容精确理解和全方位广告场景等视频智能相关领域中的经验。这些经验为爱诗科技构建了数据、算法以及工程上的竞争优势。

据 AI产品榜(aicpb.com)数据,PixVerse 产品四月访问量 165 万,位列视频生成类 AI产品全球第八,仅次于 pika,同时访问量环比增加 39.8%,增速领先同类产品。根据爱诗科技公众号新闻,2024年5月17日,智源研究院举办大模型评测发布会其中视频模型评测结果显示,爱诗科技旗下产品 PixVerse 位列全球 TOP3,在国内同类型产品中表现最佳。

以文生视频为例,用户需要输入正提示词(Prompt)与负提示词(Negative Prompt),选择视频画面风格,选择画幅比例,耗时1-2分钟,可生成4秒视频。其中,正提示词描述想要生成的画面,负提示词描述不想看到的视频元素;画面风格目前有真实、2D、3D、CG 四种:画幅比例目前有 16:9、9:16、1:1、4:3、3:4五种。提示词输入内容与风格选择不同,会影响生成视频的耗时,目前测评一般耗时约为 1-2分钟,最终可生成4 秒视频。

技术方面,在2023年爱诗科技成立之初,公司采用过Diffusion+Unet架构的技术路线,这是在Sora出现之前一种主流的文生图、文生视频模型生成路线。这个过程可以想象成将一滴墨水滴入水中,墨水逐渐扩散,而Diffusion模型需要学会如何将墨水从水中重新提取出来。

Unet架构在降低复杂度与保留细节度之间做到了很好的平衡,提升了模型的计算效率,模型的算力需求不会太高。但另一方面,如果要想模型越来越聪明,加入的参数越来越多,图像或指令变得越来越复杂,Unet架构很容易陷入性能瓶颈,面临扩展性问题。

因此,爱诗科技也尝试了Diffusion+Transformer(DiT)架构,通过Scaling Law的方式来提升模型的性能。Sora的出现验证了爱诗的早期判断正确。

除了DiT路线之外,也在探索自回归路线在文生视频模型的潜力。

王长虎表示:“爱诗科技不会局限在一种技术路线,未来会多种技术路线共同探索,一方面用Transformer路线进一步提升基座模型能力,并加入可控生成技术;另一方面会持续探索自回归路线,增强时空建模,并建立各个模态间统一范式。”

值得一提的是PixVerse在商业化推进上其实蛮快的,其付费模式采用订阅制,基础班免费,初始赠送 150 点 credits,每日赠送 50 点 credits,生成一个视频消耗 10credits;标准版:5 美元/月,每日 500credits,每月 5,000credits,理论上 30 天可以生成 2,000 个 4秒视频,换算价格为每生成 4 秒视频需要花费约 0.0025 美元/2 分人民币。标准版添加了去除水印等额外功能。此外,还有理论每个视频价格可实现无限低的无限版。

04

AI视频,巨头们的战争

AI视频需要极强的算力以及出色的算法,这绝非几个人的工作室可以完成,Vidu和PixVerse看似创业企业,可其背后站着的资方大佬和技术大佬阵营也相当华丽。

同时,对于AI视频这样一个热门赛道,百度、阿里这样的行业巨头同样也有亲身下场。

百度其实在很久之前就推出了文生视频的能力,在百度的百家号中,当用户上传文章之后,会有一部分文章被百度精选出来,自动生成视频,而在最近也发布了一款名为"UniVG"的视频生成模型,相关效果也位于除Sora之外的前列。

同时,百度作为国内深耕AI行业最深的企业,无论是算力的充足、数据的丰富还是工程能力的先进,都处于国内第一梯队,只要其以正常的速度进行推进,那么百度版的能力更强的文生视频模型,也将于未来不久上线。

而就在前不久,阿里云旗下魔搭社区(Model-Scope)上线文本生成视频大模型。目前由文本特征提取、文本特征到视频隐空间扩散模型、视频隐空间到视频视觉空间这3个子网络组成,整体模型参数约17亿。