利用 Ollama 开源模型仓库和 Obsidian 笔记软件搭建本地的大型语言模型,即大预言模型。这种方法的优势在于保护个人隐私,并能够结合个人知识库来创建个性化的模型。

Ollama 模型仓库Ollama 是一个提供多种大型语言模型的开源仓库,用户可以通过简单的命令行操作来下载和运行这些模型。文章列出了 Ollama 支持的模型及其参数、大小和下载命令,包括但不限于 Llama 3、Mistral、Dolphin Phi 等。

安装与配置 Ollama安装:到官网下载Ollama 的 Windows 版,然后一键的傻瓜式安装。

查询模型:通过 ollama list 命令可以查询已安装的模型。

运行模型:使用 ollama serve 命令在 Windows 上运行模型,支持默认开机启动。

模型安装:比如安装 llama3,只需在 cmd 中运行 ollama run llama3,便可安装并运行该模型(其他模型安装参考其他官网)。

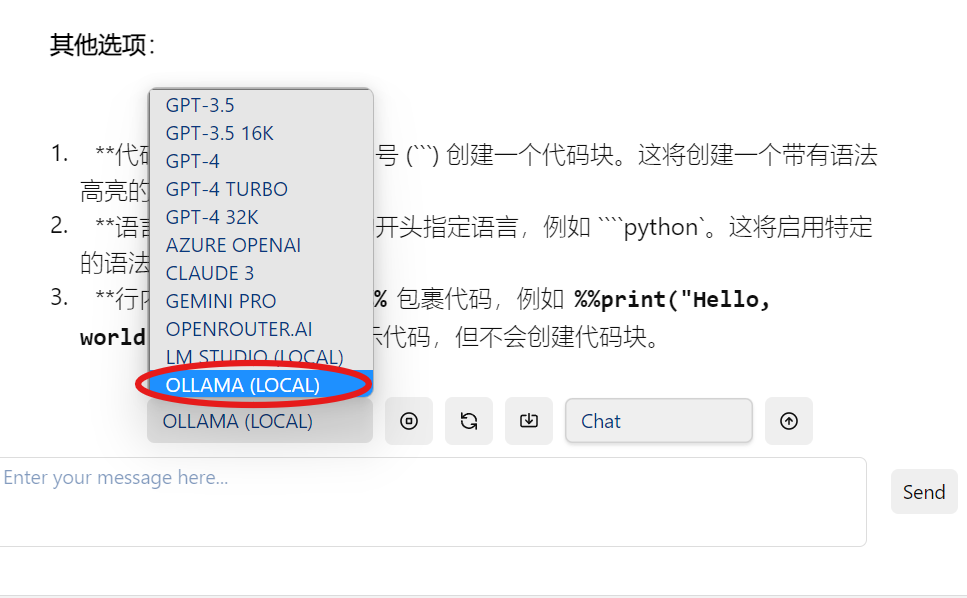

插件安装:在 Obsidian 中安装名为 copilot 的插件,该插件允许用户直接在 Obsidian 中利用 Ollama 模型。

文章指导用户如何在Obsidian插件中添加环境变量 OLLAMA_ORIGINS=app://obsidian.md*,以确保 Ollama 模型能够正确地与 Obsidian 集成。

完成上述设置后,用户可以直接在 Obsidian 中使用 Ollama 模型。文章提到了两种对话方式:

直接对话:用户可以直接与模型进行交互。